Cel bloga

Celem tego kursu jest wprowadzenie do praktyki eksploracji danych i uczenia maszynowego. Zawarte materiały należy traktować jako pierwszy krok do tej tematyki z zastosowaniem w praktyce prostych powszechnych narzędzi jak Excel, a dla bardziej zainteresowanych przedstawiona będzie możliwość zastosowania nabytej wiedzy w Java z wykorzystaniem algorytmów różnych bibliotek ze szczególnym uwzględnieniem biblioteki WEKA. Będzie też trochę matematyki, ale w zakresie jedynie koniecznym do zrozumienia danej metody rozwiązującej konkretny problem.

Eksploracja danych jest połączeniem stosowanych statystyk, logiki, sztucznej inteligencji, uczenia maszynowego i systemów zarządzania danymi. Nie jest wymagane duże doświadczenie w tych dziedzinach, aby korzystać z materiałów zawartych w tym blogu. Większość oferowanych źródeł i kursów do nauki Data Mining lub Machine Learning proponuje wykorzystanie takich programów jak RapidMiner, a dla Machine Learning programowanie w języku Pyton. Na tym blogu nie idziemy pod prąd, ale algorytm zrozumiemy wtedy, gdy zainicjujemy go krok po kroku, więc w miarę możliwości będziemy korzystać z Excel lub wizualizacji WEKA. Jeśli chodzi o Machine Learning to bazujemy na Java, główny powód, to możliwość wykorzystania dostępnych zestawów algorytmów WEKA jako możliwość stosowania w aplikacjach Javy i SPRING’a.

Co będzie potrzebne:

- Zainstalowany pakiet MSOffice z arkuszem kalkulacyjnym Excel, niestety płatny, ale można skorzystać ze starych wersji

- Zainstalowana Java 1.8 lub wyższa plus edytor np. darmowa wersja IntellJ IDEA Educational, resztę potrzebnych bibliotek dołączymy korzystając z Maven

- Zainstalowany pakiet algorytmów WEKA Waikato University Hamilton, New Zealand, pakiet jest darmowy. Do prób kontrolnych poza JAVA.

Ponadto możemy praktycznie przyjąć za pewnik dwa dogmaty:

- Wszystko co sam wymyślisz pewnie już tu jest https://stackoverflow.com/

- Jeśli jest biblioteka konkretnych algorytmów ML/AI napisana w innym języku to jest także jej odpowiednik dla Java. Algorytmy uczenia maszynowego są często najpierw tworzone w laboratoriach uniwersyteckich, w wielu językach, takich jak skrypty Shell, Python, R, MATLAB, Scala lub C ++, aby utworzyć nową koncepcję i teoretycznie przeanalizować jej właściwości. Java jest to de facto język korporacyjny, co można przypisać statycznemu typowaniu, solidnej obsłudze IDE, dobrze zdefiniowanej strukturze wzorców,i metod testowania, a także posiada przyzwoity model obsługi wątków oraz współbieżne biblioteki struktur danych o wysokiej wydajności. Konkretny algorytm może przejść długą drogę do końcowej refaktoryzacji, ale możemy przyjąć za pewnik, że prędzej czy później pojawi się w Java.

Podstawowe informacje o danych

Podział danych jest stosunkowo prosty. Dane dzielimy zasadniczo na dwa podstawowe modele tj. dane podstawowe oraz dane drugorzędne.

Dane podstawowe

Dane podstawowe są to dane które występują w swojej rzeczywistej postaci (takiej w jakiej je pozyskano) beż żadnych modyfikacji dostosowujących do dalszych obliczeń i analiz. Dane podstawowe zbierane są za pomocą różnych metod których przykłady przedstawiono poniżej:

1. Wywiad

Dane zbierane w trakcie tego procesu pochodzą z wywiadu z odbiorcami docelowymi przez osobę zwaną ankieter, a osoba, która odpowiada na wywiad, jest znana jako osoba przeprowadzająca wywiad.

2. Ankieta

Ankieta to w zasadzie proces badawczy, w którym zadaje się listę odpowiednich pytań, a odpowiedzi są zapisywane w formie tekstu, dźwięku lub wideo.

3. Eksperyment

Eksperyment to sposób zbierania danych poprzez przeprowadzanie eksperymentów, badań i śledztw oraz odpowiednim zapisywaniu obserwacji i atrybutów obserwacji. Stosuje się różne metody prowadzenia eksperymentów, istotne jest jednak to jakie wartości są elementami obserwacji i atrybutów. Mogą to być np. wartości tekstowe, obiektowe, liczbowe, logiczne mieszane.

Dane wtórne

To szczególny typ danych które zostały zebrane i innych powodów zostały zarejestrowane i mogły być poddane pewnym modyfikacjom koniecznym do ich analizy lub wynikającymi ze specyfiki ich źródła generowania. Ogólnie dane wtórne dzielimy na:

1. Dane organizacyjne

Ogólnie można przyjąć, że są to dane wynikające z działalności związanej z jakimś przedsięwzięciem. Mogą to być zapisy rynkowe, zapisy sprzedaży, transakcje, dane klientów, zasoby księgowe itp. Należy przy tym zauważyć, że koszt i czasochłonność przy pozyskiwaniu danych ze źródeł organizacyjnych jest stosunkowo niskie, wynika to po prostu z faktu, iż są one z reguły koniecznością lub wymogiem przy realizacji szeroko rozumianego przedsięwzięcia, np. bank prowadzi informacje o klientach w ramach polityki kredytowe itp.

2. Dane zewnętrzne

Ten typ danych jest elementem pochodnym działalności organizacyjnej wynikającym z samej działalności lub elementem niezbędnym do realizacji działalności. Przykładowe to np. odczyty liczników prądu mające wpływ na koszty działalności, ale fakturę otrzymujemy z od dystrybutora energii zgodnie z jego taryfikatorem. Mogą to też być statystyczne dane rządowe [GUS] mające wpływ na marketing firmy lub przedmiot działalności.

Podstawowe kategorie źródeł wydobywanych danych

1. Sety – zestawy danych płaskich lub pliki płaskie

Przykładem setu są np. dane pomiarowe jakiegoś eksperymentu w postaci pliku CSV gdzie w mamy atrybuty w postaci kolumn, argumenty i wartość wyniku/wyników dla argumentu. Set nie posiada żadnych relacji do innych tabel. Dane mogą mieć postać tekstową liczbową lub logiczną i można je wyodrębnić za pomocą algorytmów eksploracji, które przyjmiemy do ich zastosowania. Przykład – algorytm po wczytaniu pliku kasuje wiersze z wynikiem „0” ponieważ jest to wynik błędu transmisji jakichś danych

2. Relacyjne bazy danych

Bazy danych które posiadają tabele powiązane relacjami. Najczęściej posługujące się standardowym API w postaci „sequel” (Structured Query Language). W takich bazach kopanie danych nie jest łatwe, wymaga bowiem znajomości SQL. Należy pamiętać, że jest to tzw. zbiór danych zorganizowanych zarówno danych w tabeli pod względem uporządkowania według ID tabeli jak i również zdefiniowanych relacji pomiędzy tabelami. Należy zauważyć, że relacyjne bazy danych są relatywnie dość „ciężkim” tematem do kopania danych ze względu na swoją relacyjną strukturę i bardzo często taki zestaw danych poddaje się przetworzeniu do postaci „setu” gdzie w wiersze stanowią tzw. obserwacje a w kolumny atrybuty

3. Hurtownie danych ang. DataWarehouse

Hurtownie danych to nic innego jak zbiory danych zintegrowanych z wielu źródeł, który będzie służył zapytaniom i podejmowaniu decyzji. Zasadniczo wyróżniamy trzy typy hurtowni danych: hurtownia danych jako przedsiębiorstwa [Enterprise DataWarehouse] , hurtownia danych skompilowana do mniejszego rozmiaru zdefiniowanych wcześniej danych zwana magazynem danych [Data Mart] i hurtownia wirtualna [Virtual Warehouse]

4. Dane Transakcyjne lokowane w bazach danych np. eXtremeDB

Dość ważny element zbiorów danych. Częstym elementem kreowania tego typu danych jest wykorzystanie np. w SPRINGu wzorca ACID – klasy transakcji. Oznacza to zapis do bazy danych elementu transakcji, uporządkowanego wg znacznika czasu i daty (szeregów czasowych) z cechami Jednoznaczności, Spójności, Izolacji, Trwałości

- Atomic

- Consistency

- Isolation

- Durability

w powiązaniu z obiektem transakcji jak operacja giełdowa, bankowa, przyjęcia wydania z magazynu. To co należy zapamiętać to zasadę, że na tym samym obiekcie nie można wykonywać wielu transakcji w tym samym czasie. Przykład: na budowie w biurze A osoba chce pobrać np. to samo narzędzie co inna osoba w biurze B. Nie można wypożyczyć tej samej rzeczy w tym samym czasie przez dwie różne osoby. Tak więc np. jeśli biuro A było pierwsze w wątku biuro B będzie czekało na wynik transakcji i zobaczy jedynie status po operacji, że narzędzie jest już wypożyczone lub nie (jeśli np. odstąpiono od wypożyczenia w biurze A)

5. Multimedialne bazy danych np Netflix

Wszelkie zbiory danych multimedialnych jak filmy, nagrania muzyczne wraz z ich systemem ewidencji danych klientów, pobrań itd. Ważnym elementem tych baz są dane ewidencyjne i obrotu multimediów pozwalające na kopanie danych w celu przyjęcia właściwej strategii marketingowej czy kompletacji ofertowej.

6. Topograficzno-Przestrzenne bazy danych np. OpenStreet

Przykładem takich danych jest ogólnie dostępna baza społecznościowa OpenStreet. Istotne dla kopania danych są nie tylko dane topograficzne, ale zawarte w różnych warstwach dane o elementach obiektów budowlanych, zmianach przestrzennych w czasie, POI itd.

7. Sieć strony WWW

Najbardziej dynamiczne i heterogeniczne repozytorium. Odnosi się do World Wide Web to zbiór dokumentów i zasobów, takich jak audio, wideo, tekst itp., które są identyfikowane przez jednolite lokalizatory zasobów (URL) za pośrednictwem przeglądarek internetowych, połączone za pomocą stron HTML i dostępne za pośrednictwem sieci internetowej.

Data Mining, Kopanie Danych, Eksploracja Danych, KDD – Knowledge Discovery from Databases

Eksploracja danych to dyscyplina związana z pozyskiwaniem danych, ich przygotowaniem (czyszczenie, szorowanie) i metodycznym przeszukiwaniu wzorców wraz z ich analizą. Przez większość czasu nawet nie zauważamy, że to się dzieje. Przykładowo, ilekroć rejestrujemy się w celu uzyskania karty sklepowej w sklepie spożywczym, dokonujemy zakupu za pomocą karty kredytowej lub surfujemy po Internecie, generujemy dane. Dla przypadku wspomnianego powyżej beneficjentami naszych działań jest market, który rejestruje nasze dane personalne i dane o zakupionym towarze, bank, który dowiaduje się co kupujemy, gdzie kupujemy i kiedy kupujemy a Gogle skrzętnie profilują nasze poczynania w sieci. Dane te są przechowywane w dużych zbiorach na potężnych serwerach należących do firm, z którymi na co dzień mamy do czynienia. W tych zbiorach danych leżą wzorce – wskaźniki naszych zainteresowań, naszych nawyków i naszych zachowań. Eksploracja danych pozwala ludziom zlokalizować i zinterpretować te wzorce, pomagając im podejmować bardziej świadome decyzje i lepiej obsługiwać swoich klientów. To powiedziawszy, istnieją również obawy dotyczące praktyki eksploracji danych. W szczególności grupy nadzorujące ochronę prywatności głośno opowiadają się za organizacjami gromadzącymi ogromne ilości danych, z których niektóre mogą mieć bardzo osobisty charakter.

O kopaniu danych jako dyscyplinie informatycznej zaczęto mówić, kiedy w 1999 roku kilka dużych firm, w tym producent samochodów Daimler-Benz, ubezpieczyciel OHRA, producent sprzętu i oprogramowania NCR Corp. oraz producent oprogramowania statystycznego SPSS, Inc. rozpoczęły współpracę w celu sformalizowania i ujednolicenia podejścia do eksploracji danych. Efektem ich pracy był CRISP-DM, standardowy proces CRoss-Industry dla eksploracji danych.

Mimo że uczestnicy tworzenia CRISP-DM z pewnością mieli żywotne interesy w określonych narzędziach programowych i sprzętowych, proces został zaprojektowany niezależnie od konkretnego narzędzia. Został napisany w taki sposób, aby miał charakter koncepcyjny – coś, co można było zastosować niezależnie od określonego narzędzia lub rodzaju danych. Proces składa się z sześciu etapów lub faz. W poniższym rysunku przedstawiono założenia procesu. [zaczerpnięto: https://en.wikipedia.org/wiki/Crossindustry_standard_process_for_data_mining ]

Nie ma potrzeby by znać na pamięć strukturę modelu, ale warto zaznajomić się z jego elementami opisanymi poniżej

1. Business (Organizational) Understanding – zrozumienie potrzeb biznesowych

To jest absolutna baza do dalszych działań. Możesz wydobywać dane dniami i nocami, ale jeśli nie wiesz, czego chcesz się dowiedzieć, jeśli nie zdefiniowałeś żadnych pytań, na które trzeba odpowiedzieć, wtedy wysiłki związane z eksploracją danych będą mniej owocne. Zacznij od pomysłów na wysokim poziomie: co sprawia, że moi klienci tak bardzo narzekają. Jak mogę zwiększyć marżę zysku na jednostkę? Jak mogę przewidzieć i naprawić wady produkcyjne, a tym samym uniknąć wysyłki wadliwego produktu? Jeśli zrozumiesz swojego klienta i jego oczekiwania to masz 50% sukcesu w zrozumieniu jakich danych potrzebujesz

2. Data Understanding – zrozumienie danych

Po skorelowaniu i scentralizowaniu danych w organizacji pojawia się wiele pytań. Skąd pochodzą dane? Kto je zebrał i czy istniała standardowa metoda zbierania? Co oznaczają różne kolumny i wiersze danych? Czy istnieją akronimy lub skróty, które są nieznane lub niejasne? Bardzo często konieczne jest przeprowadzenie pewnych badań na etapie przygotowywania danych w ramach działań związanych z eksploracją danych. Czasami będziesz musiał spotkać się z ekspertami merytorycznymi z różnych dziedzin, aby dowiedzieć się, skąd pochodzą określone dane, w jaki sposób zostały zebrane oraz w jaki sposób zostały zakodowane i przechowywane. Niedokładne lub niekompletne dane mogą być gorsze niż nic w działalności eksploracji danych, ponieważ decyzje oparte na częściowych lub błędnych danych mogą być decyzjami częściowymi lub błędnymi.

3. Data preparation – przygotowanie danych

Dane mają wiele kształtów i formatów. Niektóre dane są liczbowe, niektóre są w akapitach tekstu, a inne w formie obrazkowej, takiej jak wykresy, wykresy i mapy. Niektóre dane są anegdotyczne lub narracyjne, takie jak komentarze do ankiety dotyczącej satysfakcji klienta lub transkrypcja zeznań świadka. Nie należy jednak odrzucać danych, które nie znajdują się w wierszach lub kolumnach liczb – czasami nietradycyjne formaty danych mogą być najbardziej bogate w informacje. Przygotowanie danych obejmuje szereg czynności. Często taki proces nazywany jest czyszczenie danych lub szorowanie danych. Mogą one obejmować łączenie dwóch lub więcej zestawów danych razem, redukowanie zbiorów danych tylko do tych zmiennych, które są interesujące w danym ćwiczeniu eksploracji danych, czyszczenie danych z anomalii, takich jak obserwacje odstające lub brakujące dane, lub ponowne formatowanie danych w celu zachowania spójności.

Przykład: W pewnej ankiecie oprócz innych danych jak np. wykształcenie, wiek itd. Jest pytanie o płeć. Przedmiotem naszych badań jest korelacja grup wiekowych vs wykształcenie vs lokalizacja. W tym przypadku nie ma znaczenia czy zaznaczono płeć i taki atrybut (kolumnę) możemy pominąć, ale gdyby takie zestawienie nie dotyczyło lokalizacji, ale podziału na płeć to rezygnacja z tego atrybutu nie ma sensu natomiast wymaga analizy czy pomijamy sygnał (wiersz) z pustym polem płeć czy nie i jaką wartość błędu popełniamy.

4. Modeling – modelowanie

Model, przynajmniej w eksploracji danych, to nic innego jak komputerowa reprezentacja obserwacji ze świata rzeczywistego. Modele to zastosowanie algorytmów do wyszukiwania, identyfikowania i wyświetlania wszelkich wzorców lub komunikatów w danych. Istnieją dwa podstawowe rodzaje lub typy modeli w eksploracji danych: te, które klasyfikują [classification] i te, które przewidują [prediction].

O klasyfikacji mówimy wtedy, kiedy dany model przypisuje pewna wartość obserwacji do konkretnej grupy.

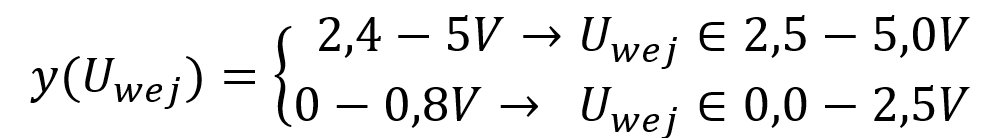

Przykład: W układach cyfrowych TTL poziom napięcia wyjściowego to przedział 0-0,8V jest klasyfikowany jako logiczne „zero”, a poziom napięcia wyjściowego w przedziale 2,4-5,0V jest sklasyfikowany jako logiczne „1”. To co pomiędzy to stan nieustalony. Jeśli na wejście układu scalonego który jest komparatorem (np. AD8469) podamy sygnał ciągły to na wyjściu układu otrzymamy tylko możliwe dwa stany napięcia tj. poziom „0” -> 0-0,8[V] lub poziom „1” -> 2,4-5,0[V]. Ogólnie możemy to sprowadzić do postaci:

O predykcji mówimy wtedy, kiedy dany model odwzorowuje w sposób ciągły pewne zachowanie.

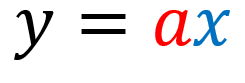

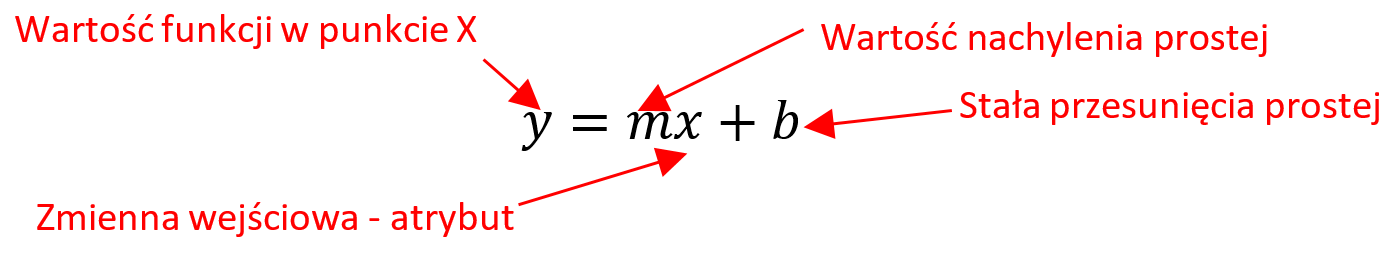

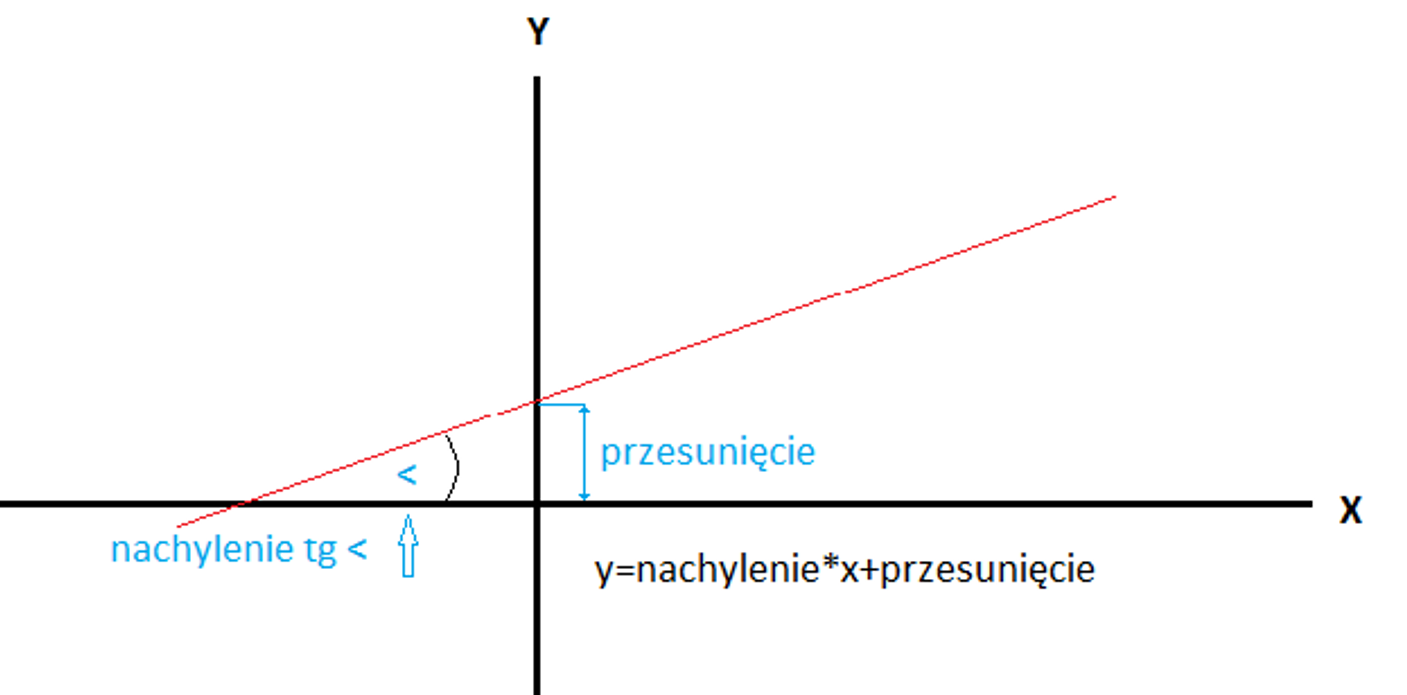

Przykład: Pomierzyliśmy prąd płynący przez rezystor dla kilku napięć np. 1V->1A; 2V->2A; 3V->3A. Nie znamy zależności (wzoru) pomiędzy prądem, napięciem stałym i rezystancją rzeczywista, ale chcielibyśmy wiedzieć jaka będzie odpowiedź modelu na argument o wartości 10V. Ogólnie model po obliczeniach przyjmie wartości równania dla predykcji liniowej w postaci ogólnej:

co odpowiada w naszym przypadku równaniu prawa Ohma I= (1/R)*U

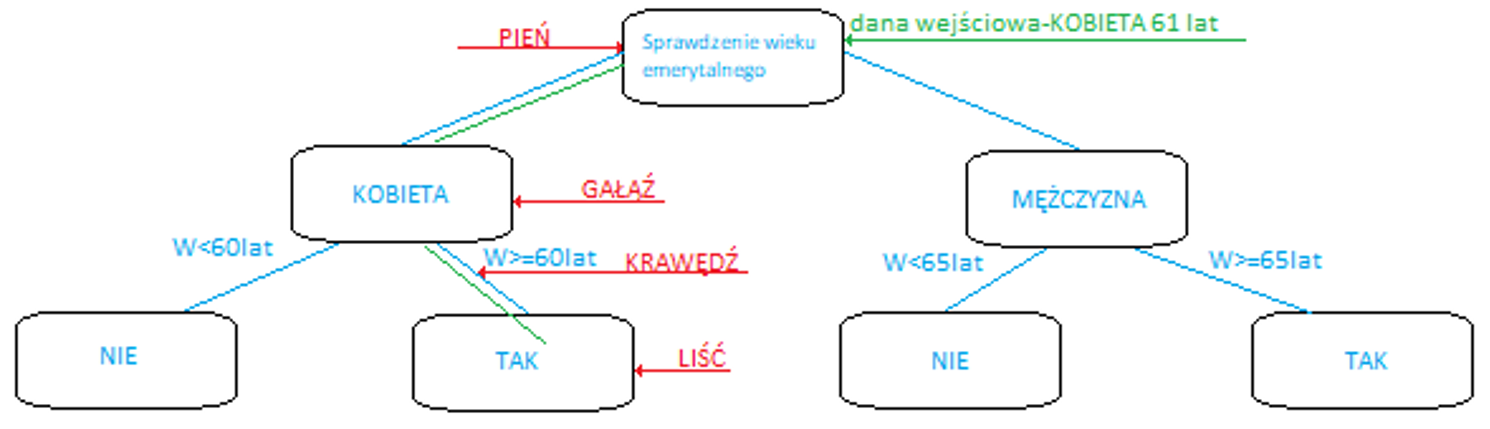

Istnieje pewne pokrywanie się między typami tych modeli wykorzystywanych do eksploracji danych. Na przykład drzewa decyzyjne. Drzewa decyzyjne to model predykcyjny używany do określania, które atrybuty danego zestawu danych są najsilniejszymi wskaźnikami danego wyniku. Wynik jest zwykle wyrażany jako prawdopodobieństwo, że obserwacja znajdzie się w określonej kategorii. Dlatego drzewa decyzyjne mają charakter predykcyjny, ale pomagają nam również klasyfikować nasze dane.

Modele mogą być proste lub złożone. Mogą zawierać tylko pojedynczy proces lub strumień albo mogą zawierać podprocesy. Niezależnie od ich układu modele są tam, gdzie eksploracja danych przechodzi od przygotowania i zrozumienia do opracowania i interpretacji

5. Evaluation – ocena

Wszystkie analizy danych mogą zawierać fałszywe alarmy. Jednak nawet jeśli model nie daje fałszywych alarmów, model może nie znaleźć żadnych interesujących wzorców w danych. Może to być spowodowane tym, że model nie jest dobrze skonfigurowany do znajdowania wzorców, możesz używać złej techniki lub po prostu w danych może nie być nic interesującego do znalezienia przez model. Faza oceny CRISP-DM ma pomóc w określeniu, jak cenny jest Twój model i co możesz chcieć z nim zrobić.

Oceny można dokonać za pomocą wielu technik, zarówno matematycznych, jak i logicznych. Jednak poza tymi środkami ocena modelu musi również obejmować aspekt ludzki. W miarę zdobywania doświadczenia i wiedzy specjalistycznej w swojej dziedzinie będą mieli wiedzę operacyjną, która może nie być mierzalna w sensie matematycznym, ale jest niezbędna do określenia wartości modelu eksploracji danych. Korzystamy zarówno wyników obliczeń opartych na danych, jak i instynktownych technik oceny w celu określenia przydatności modelu.

6. Deployment – wdrożenie

To ostatni etap prac. Czynności w tej fazie obejmują konfigurację automatyzacji modelu, spotkania z konsumentami wyników modelu, integrację z istniejącymi systemami zarządzania lub informacji operacyjnych, przekazywanie nowej wiedzy z użytkowania modelu z powrotem do modelu w celu poprawy jego dokładności i wydajności oraz monitorowanie i mierzenie wyniki stosowania modelu. Aby skutecznie wdrażać modele eksploracji danych, należy zachować równowagę. Dzięki jasnemu komunikowaniu funkcji i użyteczności modelu zainteresowanym stronom, dokładnemu testowaniu i sprawdzaniu modelu, a następnie planowaniu i monitorowaniu jego wdrażania, modele eksploracji danych można skutecznie wprowadzić do przepływu organizacyjnego.

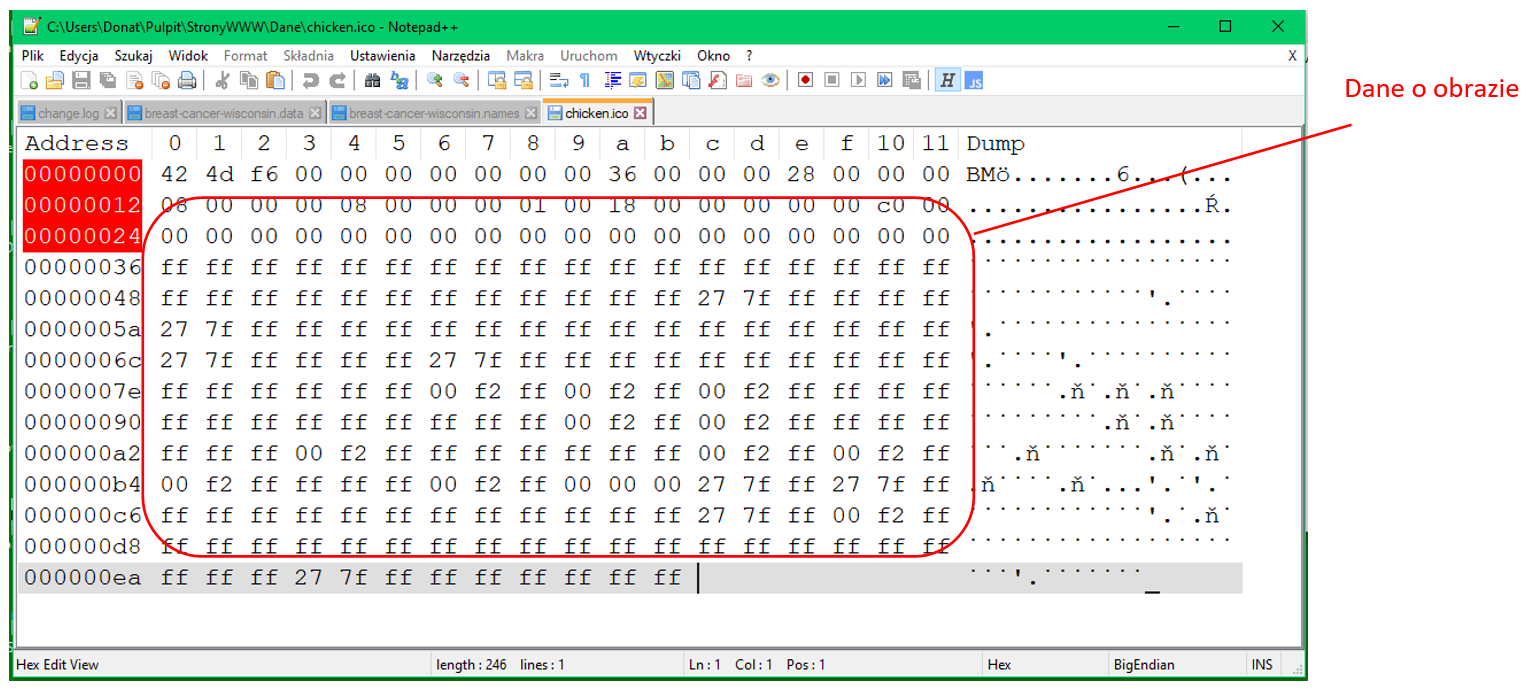

Jak widzimy dane i jak je określamy

Ponieważ będziemy poruszać pomiędzy różnymi zbiorami danych omówimy nazewnictwo, z którym spotkamy się podczas naszej pracy. W różnych środowiskach danych mogą być one określane różnymi nazwami.

W relacyjnej bazie danych wiersze będą nazywane krotkami lub rekordami, a kolumny – polami.

W hurtowniach danych i zestawach danych wiersze są czasami nazywane faktami, obserwacjami, przykładami lub przypadkami, a kolumny są czasami nazywane zmiennymi, argumentami lub atrybutami. Aby zachować spójność, będziemy używać terminologii obserwacji wierszy i atrybutów kolumn.

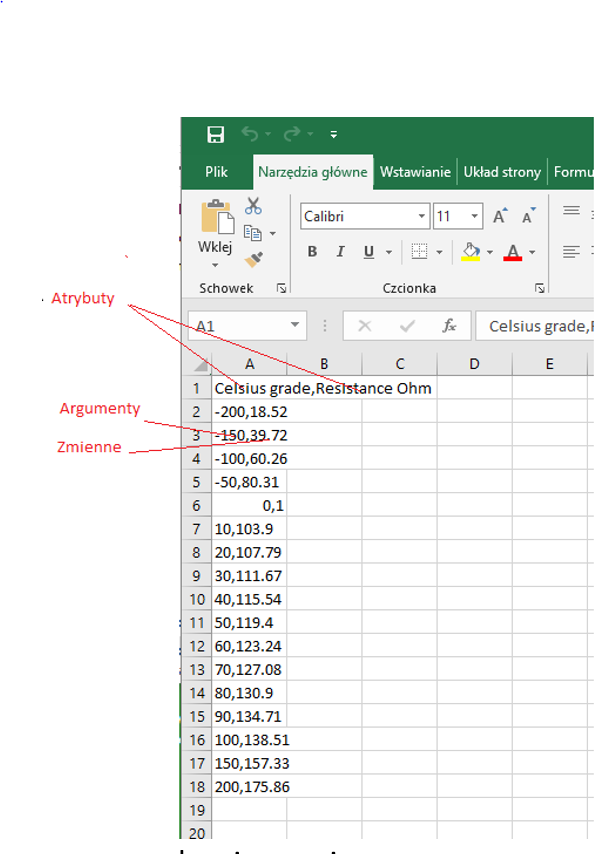

1. Data Set

W poniższym przykładzie przedstawiono pomiarowy plik CSV. Składa się on z dwóch atrybutów, z których jeden to argument drugi to zmienna.

Poszczególne dane w wierszach są odseparowane przecinkami. Wartości dziesiętne są podane z separatorem kropki. Warto zwrócić uwagę na ten fakt uwagę, gdyż często dla osób poczatkujących jest to powodem wielu pomyłek. W przykładowej zależności zaznaczonej na rysunku jako argument i zmienna zależna dla wzorcowej temperatury w komorze klimatycznej: -150oC, zmierzona rezystancja czujnika temperatury wynosiła 39,72Ω.

2. Relacyjna Baza Danych

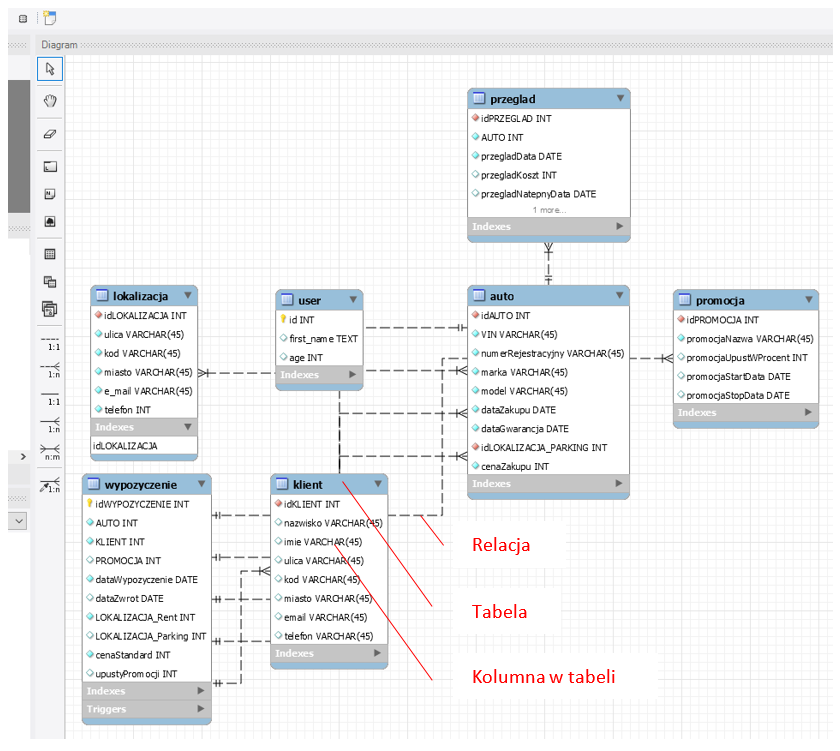

Relacyjna baza danych to zorganizowana grupa informacji w ramach określonej struktury. Kontenery bazy danych, w środowisku bazy danych nazywane są tabelami. Większość używanych obecnie baz danych to relacyjne bazy danych – są one zaprojektowane przy użyciu wielu tabel, które są ze sobą powiązane w logiczny sposób. Relacyjne bazy danych zazwyczaj zawierają dziesiątki lub nawet setki tabel, w zależności od wielkości organizacji. Załączony poniżej przykład bazy danych utworzony na potrzeby wypożyczalni samochodów pokazuje złożoność tabel i relacji

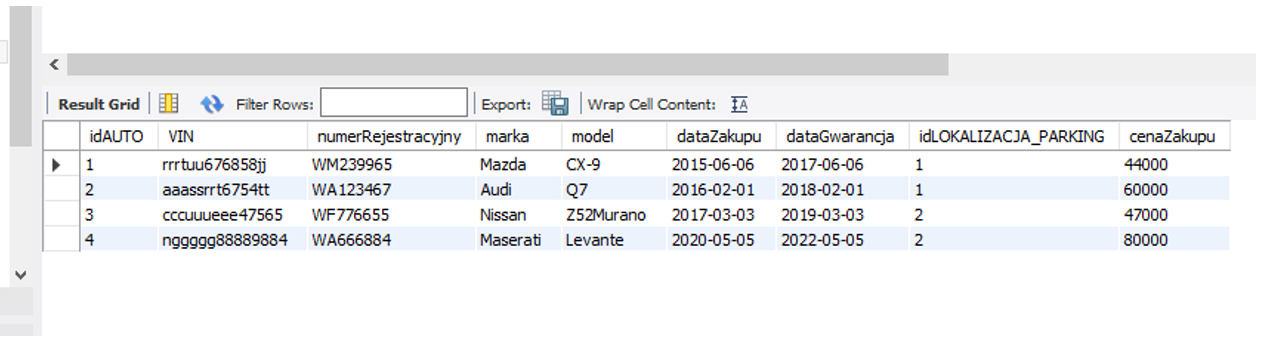

Jest to diagram gdzie każda z tabel posiada własne kolumny z atrybutami wg nazw. Jak widoczne w tabeli każda z tabel zawiera dziesiątki wierszy z danymi natomiast linie łączące tabel wskazują jakie są relacje (zależności) pomiędzy danymi w tabelach. Przykładowa tabela testowa:

Na pierwszej pozycji od lewej jest kolumna identyfikatora idAUTO łatwo zauważyć, że ta tabela przechowuje relację do tabeli z identyfikatorem idLOKALIZACJA_PARKING to jest właśnie relacja. Większość relacyjnych baz danych, które są zaprojektowane do obsługi dużej liczby odczytów i zapisów (aktualizacji i pobierania informacji), jest określanych jako systemy OLTP (przetwarzanie transakcji online). Systemy OLTP są bardzo wydajne w przypadku czynności o dużym wolumenie, takich jak kasowanie, zapis, gdzie np. wiele pozycji jest rejestrowanych za pomocą skanerów kodów kreskowych lub pobieranych z odczytów urządzeń IoT w bardzo krótkim czasie. Jednak używanie baz danych OLTP do analizy jest generalnie mało wydajne, ponieważ aby pobrać dane z wielu tabel jednocześnie, należy napisać zapytanie zawierające łączenia. Zapytanie jest prostą metodą pobierania danych z tabel bazy danych do przeglądania wyników danych w zestawieniach, które w danej chwili interesują analityka. Zapytania są zwykle pisane w języku zwanym SQL (Structured Query Language; wymawiane jako „sequel”).

3. Hurtownia danych

Hurtownia danych to rodzaj dużej bazy danych , która została zdenormalizowana i zarchiwizowana z bazy danych relacyjnej SQL. Denormalizacja to proces celowego łączenia niektórych tabel w jedną tabelę, mimo że może to spowodować zduplikowanie danych w niektórych kolumnach (lub innymi słowy, atrybutów). Denormalizacja to schematy wielowymiarowe, specjalnie zaprojektowane do modelowania systemów hurtowni danych. Głównym celem denormalizacji jest uproszczenie tabel zapytań do określonych celów biznesowych w połączeniu z odpowiednimi algorytmami czego nie da się osiągnąć w łatwy sposób metodami w standardzie SQL Schematy zostały zaprojektowane z myślą o unikalnych potrzebach bardzo dużych baz danych zoptymalizowanych do celów analitycznych (OLAP). Wyróżniamy głównie trzy typy schematów hurtowni danych:

- Schemat gwiazdy (Star Schema)

- Schemat płatka śniegu (Snowflake Schema)

- Schemat galaktyki (Galaxy Schema)

Ogólnie można powiedzieć, że wybór schematu zależy od tego co chcemy przetwarzać. Główne wymagania są następujące:

- Jakie są potrzeby biznesowe

- Jaki poziom ziarnistości musimy założyć – ile i jakich szczegółów potrzebujemy

- Ile potrzebujemy wymiarów – czyli ile tabel z jakimi danymi

- Jakie miary (wskaźniki) są nam potrzebne w wynikach

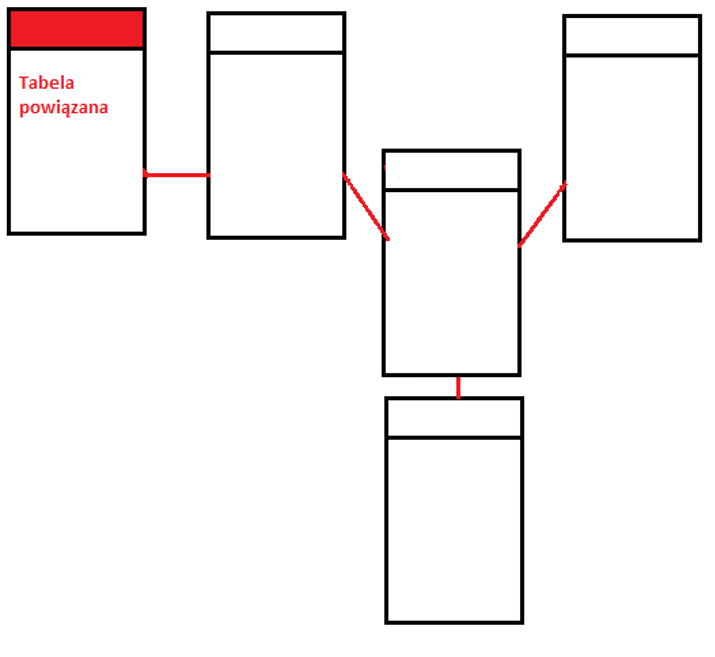

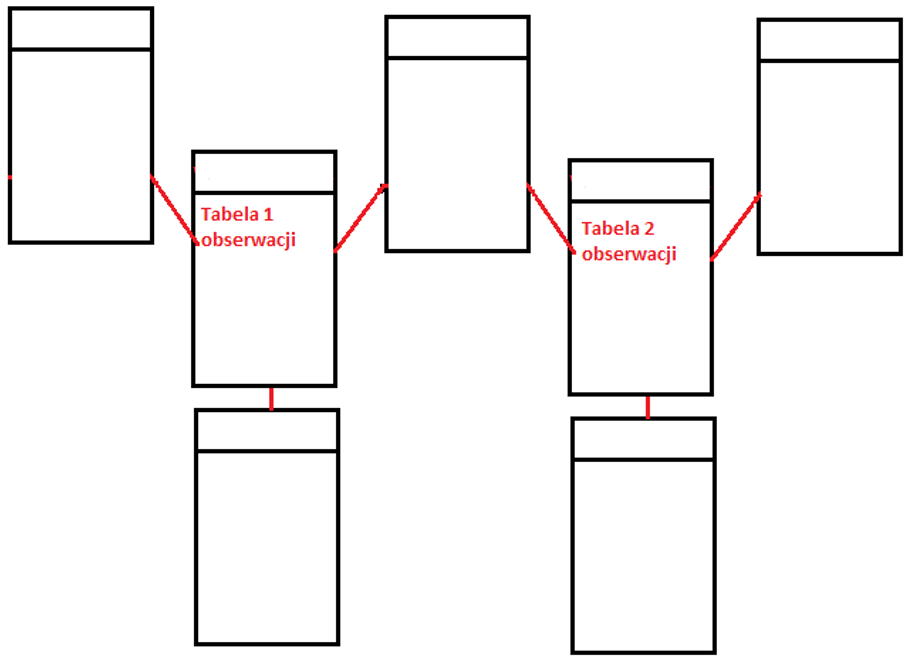

Schemat gwiazdy – z przykładem

Schemat gwiazdy w hurtowni danych, w której środek gwiazdy może mieć jedną tabelę obserwacji i kilka powiązanych tabel atrybutów. Jest znany jako schemat gwiazdy, ponieważ jego struktura przypomina gwiazdę. Model danych Star Schema to najprostszy typ schematu Data Warehouse. Przykładowo chcemy przeanalizować nasza bazę wypożyczalni pod kątem klient , model wypożyczanego samochodu, czas wypożyczenia oraz jaki przynosi zysk w naszej wypożyczalni.

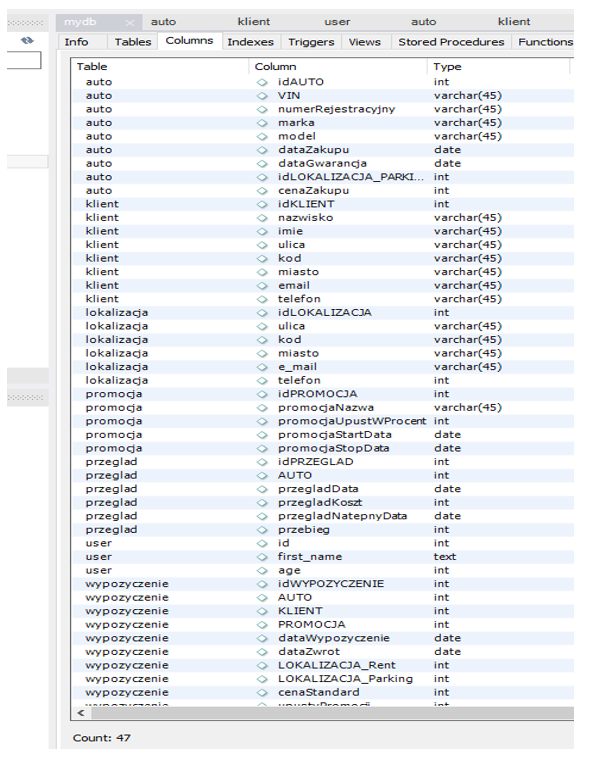

Zaczynamy – przeglądając zestawienie zbiorcze z bazy SQL przyjrzyjmy się jakie tabele zawierają dane niezbędne do pozyskania naszych wskaźników:

Cel biznesowy to zmiana parku naszych samochodów oraz wprowadzenie pewnego wątku drzewa decyzyjnego w oprogramowaniu który pomoże obsłudze w decyzji któremu klientowi dać priorytet strategiczny a któremu „podziękować” w sytuacji kolizji oczekiwań.

Ziarnistość potrzebujemy dane o klient-> samochód->przychód

Atrybuty potrzebujemy tabeli o klientach, wypożyczeniach, samochodach, przychodach, promocjach

Wskaźniki ID Klienta, przychód

Centrum gwiazdy – co jest obserwacją lub prościej co jest kluczem pozostałych tabel w bazie SQL wypożyczalni powyżej? Jest to tabela wypożyczenia. Zatem, nasza gwiazda powinna wyglądać następująco:

Schemat płatek śniegu

Płatek śniegu jest ewolucją gwiazdy. W zasadzie tego typu schemat jest pochodna tradycyjnej bazy danych którą zdenormalizowano, ale optymalizacja wymusza konieczność dodatkowych tabel. Główną zaletą schematu płatka śniegu jest to, że zajmuje mniej miejsca na dysku niż odpowiadająca mu baza danych SQL. Do schematu gwiazdy dodawany jest łatwiejszy do zaimplementowania wymiar. Z powodu dodatkowego odniesienia wielu tabel wydajność zapytań jest zdecydowanie zmniejszona, schemat poglądowy poniżej.

Schemat galaktyka

Schemat galaktyki zawiera dwie tabele obserwacji, które mają wspólne tabele wymiarów. Jest również nazywany schematem konstelacji obserwacji. Ten schemat jest postrzegany jako zbiór gwiazd, stąd nazwa Galaxy Schema.

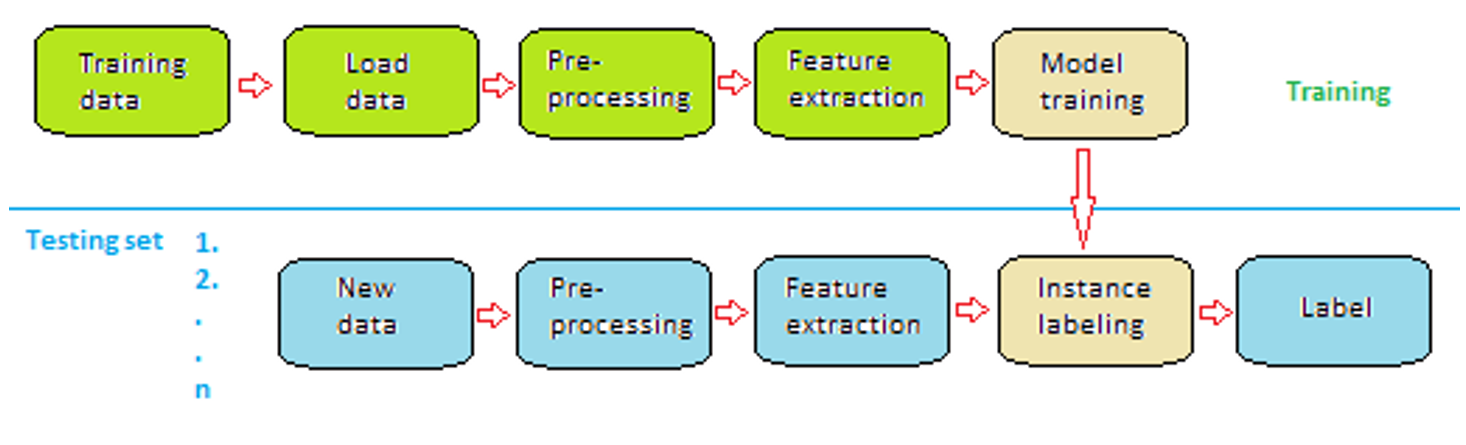

Machine Learning – uczenie maszynowe

Są trzy główne sposoby uczenia się, jak pokazano na poniższej liście:

- Supervised learning – uczenie nadzorowane

- Unsupervised learning – uczenie nienadzorowane

- Reinforcement learning – uczenie wzmocnione

Uczenie nadzorowane

Biorąc pod uwagę zestaw przykładowych danych wejściowych x i ich wyników y, uczenie nadzorowane ma na celu nauczenie odwzorowania jako funkcja odwzorowania f, która przekształca wejścia na wyjścia w postaci funkcji

Przykład: Wykrywanie oszustw związanych z kartami kredytowymi, gdzie algorytm uczenia się jest zestawiony z transakcjami kartą kredytową (macierz X) oznaczonymi jako normalne lub podejrzane (wektor Y). Algorytm uczący się tworzy model decyzyjny, który oznacza niewidoczne transakcje jako normalne lub podejrzane (jest to funkcja f). Oczywiście by taką funkcje wyznaczyć musimy posiadać zestawu danych z hurtowni danych. W tym wypadku dwa zestawy danych tj. zestaw transakcji, które bank kolekcjonuje w swoich zasobach i zestaw danych które są oznaczone w tym banku lub w hurtowni między wieloma bankami jako oszustwo.

Wyróżniamy dwa główne typy uczenia nadzorowanego

- Regresja – zmienna wyjściowa jest ciągła np. czas rezystancja temperatura

- Klasyfikacja – zmienna wyjściowa przyjmuje konkretną sklasyfikowaną wartość np. True , False, biały, czarny

Zastosowanie:

- Predykcja (prognoza) używamy zestawu zmiennych objaśniających(argumentów), aby przewidzieć wartość jakiejś zmiennej odpowiedzi (np. dla termometru oporowego wykonaliśmy pomiary temp->rezystancja dla -5oC; 0oC; 5oC; 20oC po obliczeniu zależności R=f(temp) używając modelu [wzoru], możemy podać rezystancję termometru oporowego dla temperatury np. 100oC dla której nie wykonano pomiaru rzeczywistego)

- Wnioskowanie (inference) używamy by określić w jaki sposób zmienia się zmienna odpowiedzi, gdy zmienia się wartość zmiennych objaśniających (np. zrobiliśmy pomiary jak dla punktu powyżej, ale mamy teraz do dyspozycji omomierz i chcemy się dowiedzieć jaka mierzymy temperaturę na podstawie wskazań omomierza)

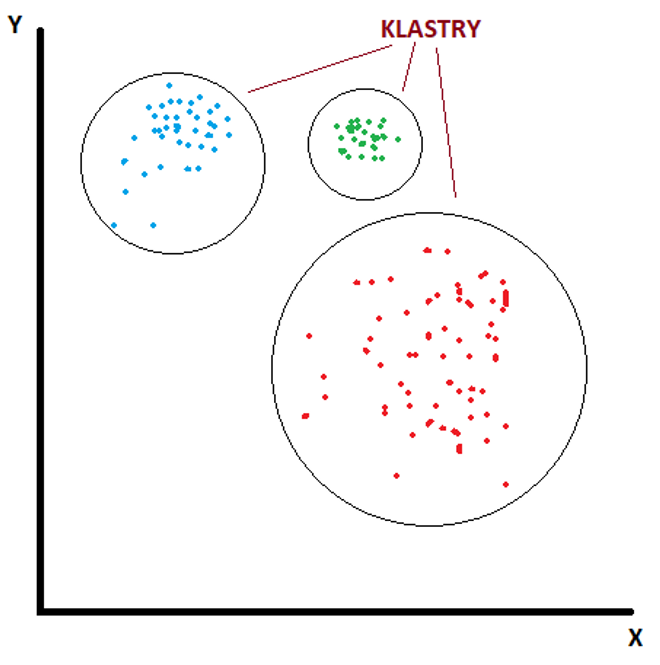

Uczenie nienadzorowane

W przeciwieństwie do nadzorowanego, nienadzorowane algorytmy uczenia się nie przyjmują podanych etykiet wyników, ale skupiają się na poznaniu struktury danych, na przykład na grupowaniu podobnych danych wejściowych w klastry. Uczenie bez nadzoru może zatem odkryć ukryte wzorce w danych.

Przykład: Algorytm rekomendacji oparty na przedmiotach, podmiotach w którym algorytm wykrywa podobne przedmioty kupione razem; na przykład osoby, które kupiły książkę A kupowały również książkę B.

Oznacza to, że nasz algorytm rozpoznaje grupy klientów, którzy mogą mieć podobne zainteresowania. Grupuje tych klientów w kategorie i proponuje zakup przedmiotów które w tej kategorii były również przedmiotem zakupów. Kupiłeś książkę kucharską na temat potraw z ryb. Jak widzi to algorytm:

- Zalicza podmiot do kategorii gotowanie i proponuje inne książki kucharskie i dołącza reklamy marketów z żywnością itd.

- Zalicza podmiot do kategorii wędkarstwo proponuje książki dot. wędkowanie i dołącza reklamy sklepów wędkarskich itd.

- Zalicza podmiot jako zainteresowany wypoczynkiem nad wodą, potrawami z ryb, owoców morza i dołącza reklamy na temat zorganizowanych podróży nad morza i akweny wodne oraz reklamuje odpowiednio skonfigurowane dane o hotelach

Podsumowując, algorytm uczenia się bez nadzoru może być użyty, gdy mamy listę zmiennych (X1, X2, X3,…, Xp) i chcielibyśmy po prostu znaleźć podstawową strukturę lub wzorce w danych. Wyróżniamy dwa główne typy uczenia nienadzorowanego

- Grupowanie (Clustering) używając tego typu algorytmów, próbujemy znaleźć „skupiska” obserwacji w zbiorze danych, które są do siebie podobne.

- Skojarzenie (Association) używając tego typu algorytmów, próbujemy znaleźć „reguły”, których można by użyć do narysowania skojarzeń.

Zastosowanie

- Grupowanie jest często używane, gdy chcemy zidentyfikować klastry klientów o podobnych nawykach zakupowych, abyśmy mogli stworzyć określone strategie marketingowe skierowane do określonych klastrów

- Skojarzenie, najczęściej stosowane by opracować algorytm asocjacyjny, który mówi, że „jeśli klient kupi produkt X, jest wysoce prawdopodobne, że kupi również produkt Y” na podstawie zebranych danych „obserwacji” z koszyka zakupów.

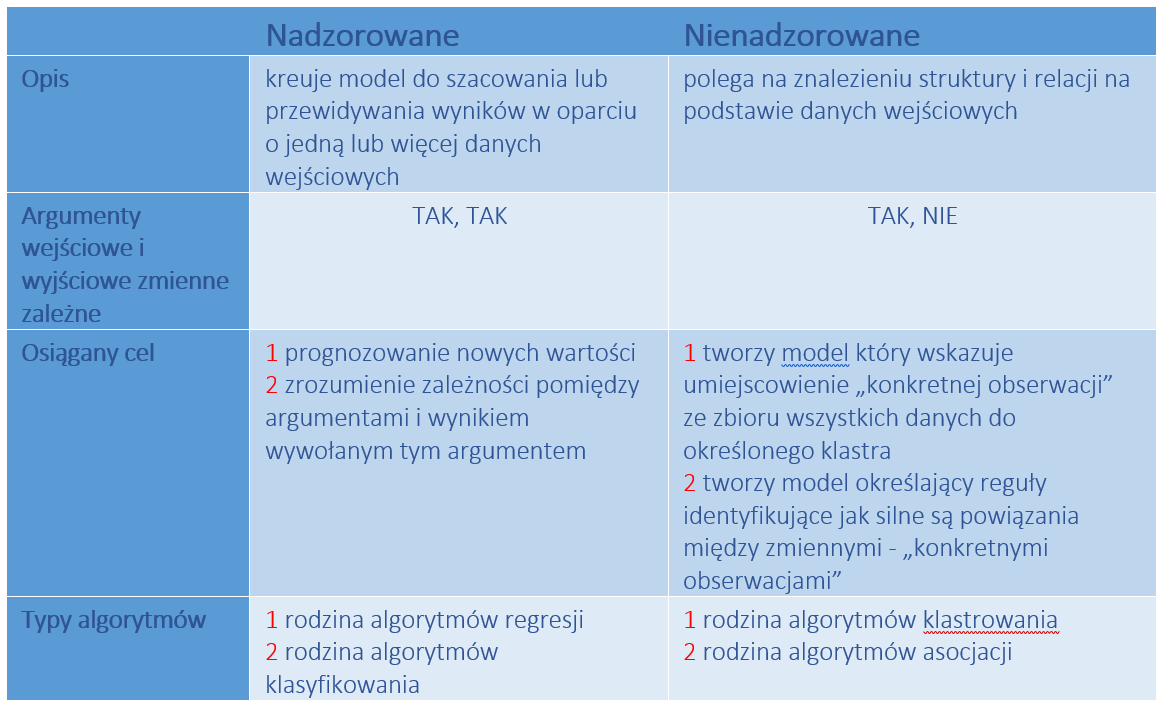

Podsumowanie Algorytmów nadzorowanych vs nienadzorowanych

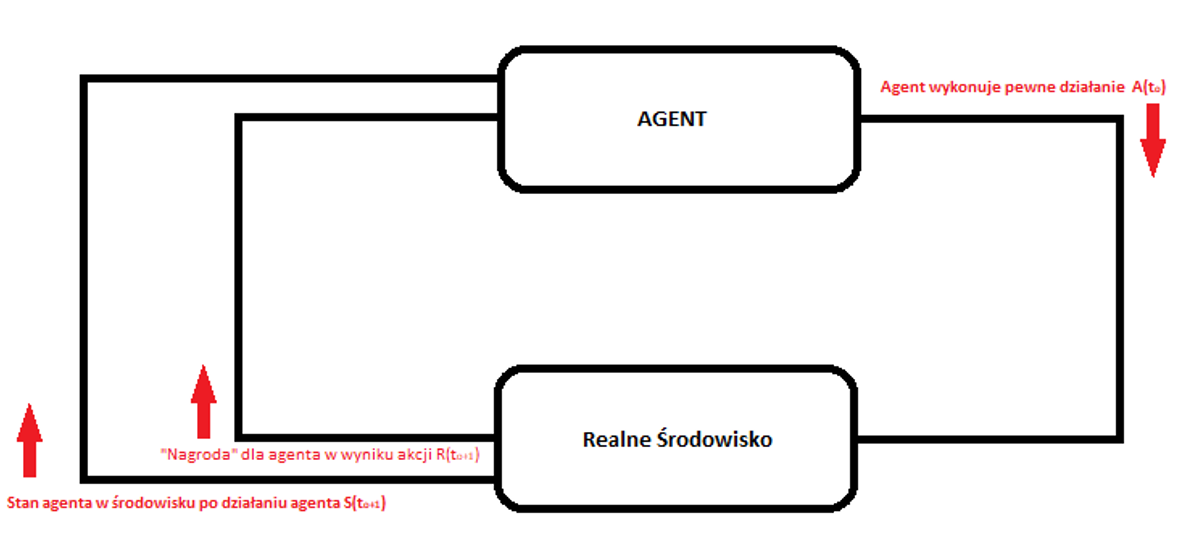

Uczenie wzmocnione Reinfoced Learning

Uczenie się ze wzmocnieniem odnosi się do procesu uczenia się z zupełnie innego punktu widzenia. Wprowadza status agenta. Agent, którym może być robot, bot lub program komputerowy. Oprogramowanie oddziałuje na utworzone pliki i dynamiczne wprowadza dane o środowisku, w którym funkcjonuje do osiągnięcia określonego celu. Środowisko jest opisane za pomocą zestawu danych, w którym agent przyjmuje określone stany i w związku z tym agent może podejmować różne działania, aby przejść z jednego stanu do drugiego. Stany mogą przyjmować różne wartości np. stan celu, a jeśli agent osiągnie ten stan, otrzymuje dużą nagrodą jako wartość „true”. W innych stanach nagroda jest mniejsza np. „null”, nie istnieje, a nawet „false”. Celem uczenia się ze wzmocnieniem jest znalezienie optymalnej polityki lub funkcji mapowania, która określa działania, jakie należy podjąć w każdym ze stanów, bez nauczyciela, który wyraźnie powiedziałby, czy to prowadzi do stanu celu, czy nie.

Przykład: Labirynt. Możemy stosować wiele algorytmów do przeszukiwania labiryntu, ale nam chodzi o inna analizę. Potraktujmy naszego agenta jak żywą istotę, która szuka drogi do celu. Nasze zadanie to

- Znaleźć cel w pierwszym kroku

- Znaleźć najkrótszą drogę.

Mamy świadomość, że maszerując po labiryncie musimy przyjąć system oznaczania swoich dróg typu „tu byłem”, „poszedłem w ten korytarz”, „cofnąłem się tutaj i idę do innego korytarza” itd. W ten sposób wprowadzam do programu określone stany agenta a zapamiętuję je zapisując do pliku/plików. To nic innego jak algorytm uczący się który tworzy politykę, określa działanie, które ma być podejmowane w określonych konfiguracjach przeszukiwanych korytarzy. W końcu nasz agent znalazł cel i jest nagroda. Nasz algorytm zapamiętuje drogę, ale czy jest ona optymalna? Niestety nasz agent będzie musiał powtórzyć przeszukiwanie z uwzględnieniem korytarzy, których jeszcze nie odwiedził, ponieważ być może jest inna krótsza droga. Odkrywane kolejne drogi wzmacniają nasze optimum. Na końcu naszych obliczeń zestawiamy wszystkie drogi i wyliczamy najkrótszą, nasz cel jest osiągnięty. Zapamiętując algorytm możemy wywołać dla niego najkrótszą drogę odwołując się do powiązanego z nim pliku, nasz agent już wie jak ma się zachować w przypadku tego labiryntu. (tej sytuacji/polityki, którą zastał).

Schemat obiegu danych dla Reinfoced Learning

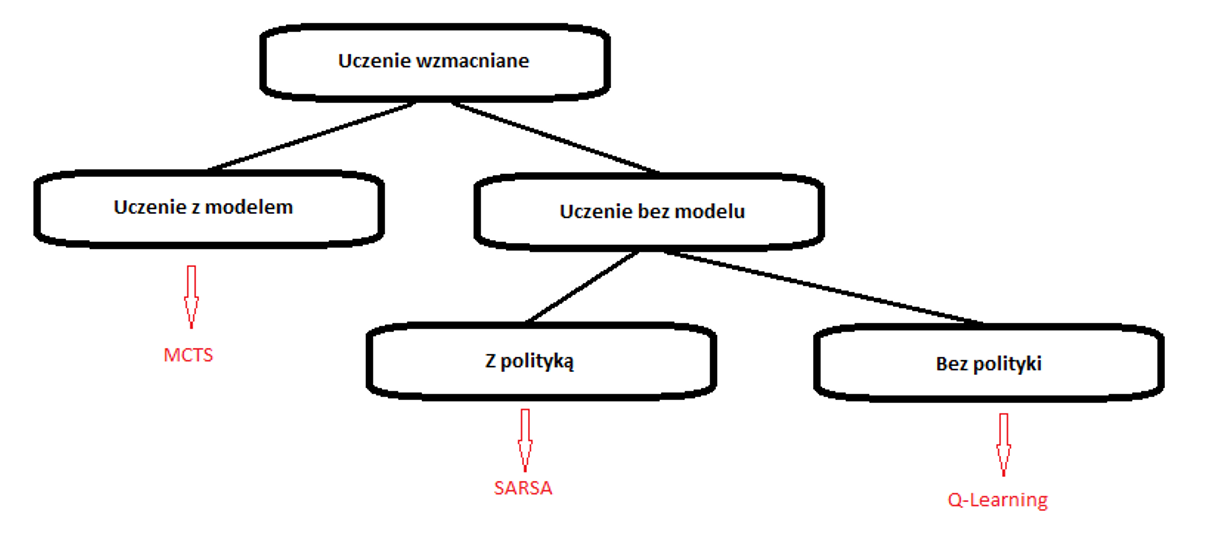

Wyróżniamy następujące główne typy uczenia Reinforced Learning

Grupa algorytmów wolnych od modeli:

Q-learning jest metodą spoza polityki, w której agent uczy się wartości na podstawie akcji pochodzącej z innej polityki,

SARSA jest metodą działającą w ramach polityki, w której agent uczy się wartości na podstawie bieżącego działania i wyprowadzonego od następnej polityki. Oznacza to że SARSA prowadzi pewna politykę kontroli własnych działań

Różnicę pomiędzy algorytmami najbardziej obrazowo wyjaśnia tzw. nauka chodzenia po klifie w taki sposób by z niego nie spaść. Problem omówiony jest szczegółowo tutaj https://studywolf.wordpress.com/2013/07/01/reinforcement-learning-sarsa-vs-q-learning

Grupa algorytmów bazujących na modelu. W tej grupie przedstawicielem wiodącym jest algorytm:

MCTS (Monte Carlo Tree Search) – jak sama nazwa wskazuje, to sposób na przeszukiwanie drzewa. Wewnątrz tego drzewa jego węzły reprezentują stany, a krawędź między węzłami reprezentuje wybór, którego podjąłby się przy przejściu z jednego stanu do drugiego. Algorytmy Monte Carlo to klasa algorytmów probabilistycznych. Oznacza to, że algorytm zwykle zwraca tylko przybliżenie rzeczywistego wyniku. Ale w kilku przypadkach udowodniono, że dąży do rzeczywistego wyniku, gdy ilość iteracji zmierza do nieskończoności.

Żeby zrozumieć sens drzewa Monte Carlo najłatwiej jest zacząć od zrozumienia analizy Monte Carlo. Samo podejście Monte Carlo jest szeroko stosowane w elektronice i wykorzystywane jest w analizie obniżenia kosztów produkcji. Najprościej przedstawić to na przykładzie dziury w płocie. Mamy czarny płot i dziurę w płocie, która ma nieznany kształt i na dodatek jest na czarnym tle. Z daleka nie widzimy ani dziury ani nie wiemy, gdzie ona jest. Ale wymyśliliśmy, że postrzelamy sobie w ten płot karabinkiem do paintball np. z czerwoną farbą. Jeśli trafimy w płot to farba się rozleje. Jeśli trafimy w dziurę to kula z farba przeleci i nie pozostawi śladu. Oczywiście nasza farba do kontrast decyzyjny. Strzelając raz przy razie wykryjemy wszystkie dziury, a obstrzeliwując każdą z nich dowiemy się jakie mają kształty. Więcej informacji jest tutaj https://medium.com/@pedrohbtp/ai-monte-carlo-tree-search-mcts-49607046b204

Podstawowa mapa algorytmów klasy reinfoced learning.

Biblioteki Machine Learning

Wiele bibliotek ML typu open souce można znaleźć na portalu https://mloss.org/software/. Poniższe zestawienie obejmuje biblioteki najbardziej znane i stosunkowo powszechnie używane.

WEKA

Waikato Environment for Knowledge Analysis (WEKA) to biblioteka do uczenia maszynowego, która została opracowana na Uniwersytecie Waikato w Nowej Zelandii i jest prawdopodobnie najbardziej znaną biblioteką Java. Jest to biblioteka ogólnego przeznaczenia, która jest w stanie rozwiązać wiele różnych zadań uczenia maszynowego, takie jak klasyfikacja, regresja i grupowanie. Posiada graficzny interfejs użytkownika, interfejs wiersza poleceń i Java API. Weka jest dostępna pod adresem https://www.cs.waikato.ac.nz/ml/weka/. Graficzne interfejsy dobrze nadają się do eksploracji danych, podczas gdy interfejs API języka Java umożliwia opracowywanie nowych schematów uczenia maszynowego i korzystanie z algorytmów w tworzonych aplikacjach. Weka jest rozpowszechniana na podstawie licencji GNU (GNU GPL), co oznacza, że można ją kopiować, rozpowszechniać i modyfikować. nawet rozpowszechniać to komercyjnie, ale trzeba wtedy uzyskać licencję komercyjną. Oprócz kilku obsługiwanych formatów plików, Weka oferuje własny domyślny format danych, ARFF, aby opisać dane za pomocą par atrybut->dane. Składa się z dwóch części. Pierwsza część zawiera nagłówek, który określa wszystkie atrybuty i ich typy, np. nominalne, liczba, data i ciąg. Druga część zawiera dane, w których odpowiada każda linia do instancji. Ostatni atrybut w nagłówku jest niejawnie uznawany za zmienną docelową a brakujące dane są oznaczone znakiem zapytania. Na podanej powyżej stronie można znaleźć odnośnik do dokumentacji produktu i organizacji inteface API Java WEKA.

Java-ML

Java Machine Learning Library (Java-ML) to zbiór algorytmów uczenia maszynowego i jest skierowany przede wszystkim do inżynierów oprogramowania i programistów. Java-ML zawiera algorytmy do wstępnego przetwarzania danych, wyboru cech, klasyfikacji i grupowania. Ponadto zawiera kilka mostków do Weka, aby uzyskać bezpośredni dostęp do algorytmów Weka API Java-ML. Można go pobrać ze strony http://java-ml.sourceforge.net/ . Java-ML to także biblioteka do uczenia maszynowego ogólnego przeznaczenia. W porównaniu do Weka oferuje bardziej spójne interfejsy i implementacje najnowszych algorytmów, których nie ma w innych pakietach, takie jak na przykład dynamiczne dopasowanie czasu (DTW), random forest, itd. Java-ML jest również dostępna na licencji GNU GPL i obsługuje wszystkie typy plików, o ile zawierają one jedną próbkę danych w każdym wierszu i poszczególne dane są oddzielone symbolem, takim jak przecinek, średnik lub tabulator.

Apache Mahout

Projekt Apache Mahout ma na celu stworzenie skalowalnej biblioteki uczenia maszynowego. Jest zbudowany na skalowalnych, rozproszonych architekturach, takich jak Hadoop, przy użyciu paradygmatu MapReduce. MapReduce służy do przetwarzania i generowania dużych zbiorów danych z wykorzystaniem klastrów. Mahout posiada interfejs konsoli i Java API jako skalowalne algorytmy do klastrowania, klasyfikacji i filtrowanie. Potrafi rozwiązać trzy problemy biznesowe:

- Polecenie pozycji: polecanie rzeczy, takich jak osoby, którym spodobał się ten film też się podobało

- Grupowanie: sortowanie dokumentów tekstowych w grupy dokumentów powiązanych tematycznie

- Klasyfikacja: wspiera w pozycjonowaniu, jaki temat przypisać do dokumentu bez etykiety

Mahout jest rozpowszechniany na przyjaznej komercyjnie licencji Apache, co oznacza, że można go używać, o ile zostanie dołączona licencja Apache i wyświetlana jest w produkowanym programie Informacja o prawach autorskich. Biblioteka jest do pobrania ze strony https://mahout.apache.org/

Apache Spark

Apache Spark, to platforma do przetwarzania danych na dużą skalę Hadoop, ale w przeciwieństwie do Mahout nie jest powiązany z paradygmatem MapReduce. Zamiast tego używa pamięci podręcznych w pamięci do wyodrębnienia roboczego zestawu danych, przetworzenia go i powtórzenia zapytania. Jest to raportowane do dziesięciu razy szybciej niż implementacja Mahouta, która działa bezpośrednio z danymi przechowywanymi na dysku. Można go pobrać z https://spark.apache.org/ . Istnieje wiele modułów zbudowanych na platformie Spark, na przykład GraphX do przetwarzania wykresów. Przesyłanie strumieniowe do przetwarzania strumieni danych w czasie rzeczywistym i MLlib dla biblioteki uczenia maszynowego obejmująca klasyfikację, regresję, wspólne filtrowanie, grupowanie, wymiarowość redukcja i optymalizacja. Spark’s MLlib może używać źródła danych opartego na Hadoop, na przykład Hadoop Distributed File System (HDFS) lub HBase, a także pliki lokalne. Obsługiwane są następujące typy danych:

- Lokalne wektory – są przechowywane na jednym komputerze. Gęste wektory są przedstawiane jako tablica wartości podwójnie wpisanych, na przykład (2,0, 0,0, 1,0, 0,0), podczas gdy wektor rzadki jest przedstawiany przez rozmiar wektora, tablicę indeksów i tablicę wartości, na przykład [4, (0, 2), (2.0, 1.0)].

- wektory w rzadkich reprezentacjach są: długie (długość |V|= 20 000 – 50 000) i rzadkie (większość elementów to 0 czyli maja dużą liczbę zer)

- wektory w gęstych reprezentacjach są: krótkie (długość 50-1000) i gęste (większość elementów to nie 0)

- Punkt oznaczony (labeled point) – który jest używany do nadzorowanych algorytmów uczenia się i składa się z lokalnego wektora jest oznaczony podwójnie wpisanymi wartościami klas. Etykieta może być indeksem klasy, wynik binarny lub lista wielu indeksów klas (klasyfikacja wieloklasowa). Na przykład oznaczony gęsty wektor jest przedstawiany jako [1,0, (2,0, 0,0, 1,0, 0,0)].

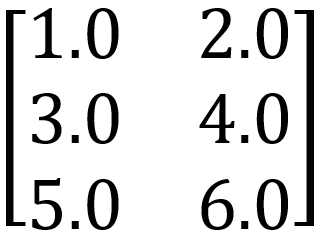

- Macierze lokalne – które przechowują gęstą macierz na pojedynczej maszynie. Macierz lokalna zawiera indeksy wierszy i kolumn zapisywane w postaci liczb całkowitych oraz wartości, przechowywane na jednym komputerze. MLlib obsługuje gęste macierze, których wartości wejściowe są przechowywane w jednowymiarowej tablicy. Na przykład poniższa gęsta macierz

Może być zapisana jako jednowymiarowa tablica [1.0, 3.0, 5.0, 2.0, 4.0, 6.0] z indeksem wymiaru matrycy (3 2) - Rozproszone macierze – działają na danych przechowywanych w Resilient Distributed. Zestaw danych (RDD), który reprezentuje zbiór elementów, na których można operować równolegle. Istnieją trzy reprezentacje:

- macierz wierszy,

- indeksowana macierz wierszy

- macierz współrzędnych

więcej informacji można znaleźć pod linkiem https://spark.apache.org/docs/2.2.0/mllib-data-types.html

Deeplearning4j

Deeplearning4j lub DL4J to biblioteka do głębokiego uczenia napisana w języku Java. Jest także dostępna jako platforma głębokiego uczenia na pojedynczym komputerze, która obejmuje i obsługuje różne platformy struktury sieci neuronowych takie jak sieci neuronowe z wyprzedzeniem, RBM, konwolucyjne sieci neuronowe, sieci głębokich przekonań, autokodery i inne. DL4J może rozwiązywać różne problemy, takie jak identyfikacja twarzy, głosów, spamu lub oszustw w handlu elektronicznym. Deeplearning4j jest rozpowszechniany na licencji Apache 2.0. do pobrania tutaj https://deeplearning4j.org/

Mallet

Machine Learning for Language Toolkit (MALLET) to duża biblioteka algorytmów i narzędzi do przetwarzania naturalnego języka. MALLET być używany w różnych zadaniach, takich jak klasyfikacja dokumentów, grupowanie dokumentów, wyodrębnianie informacji i modelowanie tematów. Zawiera interfejs wiersza poleceń, a także interfejs API języka Java dla kilku algorytmów, takich jak Naiwny Bayes, HMM, utajone modele tematyczne Dirichleta, regresja logistyczna i warunkowa pola losowe. MALLET jest dostępny na zasadach Common Public License, co oznacza, że możnago używać w zastosowaniach komercyjnych. Można go pobrać ze strony http://mallet.cs.umass.edu/. Instancja MALLET jest reprezentowana przez nazwę, etykietę, dane i źródło. Istnieją dwie metody importowania danych do formatu MALLET

- Instancja na plik

- Wystąpienie w wierszu

Encog Machine Learning Framework

Encog to framework do uczenia maszynowego w Javie / C #, który został opracowany przez Jeffa Heatona, naukowca, specjalisty analizy danych. Obsługuje normalizację i przetwarzanie danych oraz szereg zaawansowanych algorytmów taki jak SVM, sieci neuronowe, sieci bayesowskie, ukryte modele Markowa. Programowanie genetyczne i algorytmy genetyczne. Jest aktywnie rozwijany od 2008 roku. Obsługuje wielowątkowość, co zwiększa wydajność w systemach wielordzeniowych. Można go znaleźć pod adresem https: https://www.heatonresearch.com/encog/ .

ELKI

ELKI jest biblioteką do tworzenia aplikacji KDD obsługiwanych przez struktury indeksowe, z naciskiem na uczenie się bez nadzoru. Zapewnia różne implementacje do analizy skupień do wykrywania wartości odstających. Zapewnia struktury indeksów, takie jak R * -tree, w celu zwiększenia wydajności i skalowalności. Do tej pory jest szeroko stosowany w obszarach badawczych przez studentów i wydziały, a ostatnio zyskał zainteresowanie innych stron. ELKI używa licencji AGPLv3 strona biblioteki https://elki-project.github.io

Opis R*-tree https://en.wikipedia.org/wiki/R*_tree

KDD – Knowledge Discovery from Databases – zwany także Data Mining – zbiór technik obsługi baz danych, statystyki i uczenia maszynowego.

MOA

Massive Online Analysis (MOA) to profesjonalna kolekcja różnych algorytmów uczenia maszynowego, które obejmują algorytmy klasyfikacji, regresji, grupowania, wykrywania wartości odstających, wykrywania dryfu koncepcji i systemu rekomendacji oraz narzędzia do oceny. Wszystkie algorytmy są przeznaczone do uczenia maszynowego na dużą skalę, z koncepcją dryftu i obsługują duże strumienie danych w czasie rzeczywistym. Działa również i dobrze integruje się z Weka. Jast dostępna jako licencja GNU i można ja pobrać ze strony https://moa.cms.waikato.ac.nz

Wstęp do metod Machine Learning podstawowe pojęcia

Normalizacja danych (zdemoralizowane SQL)

Techniki normalizacji danych dostosowują zbiór danych do formatu, którego algorytm uczenia maszynowego oczekuje jako dane wejściowe, a nawet mogą pomóc algorytmowi w szybszej nauce i osiągnięciu lepszej wydajności.

Wiele zestawów narzędzi do uczenia maszynowego automatycznie normalizuje i standaryzuje dane. Główne cele normalizacji to

- Organizacja danych tak, aby wyglądały podobnie we wszystkich rekordach i polach.

- Zwiększa spójność typów wejść, prowadząc do oczyszczania, generowania potencjalnych klientów, segmentacji i wyższej jakości danych.

- Eliminacja nieustrukturyzowanych danych i nadmiarowości (duplikatów) w celu zapewnienia logicznego przechowywania danych

Wyróżniamy następujące formy normalizacji.

- 1NF

Najbardziej podstawową formą normalizacji danych jest 1NFm, która zapewnia brak powtarzających się wpisów w grupie. Aby każdy wpis został uznany za 1NF, musi mieć tylko jedną pojedynczą wartość dla każdej komórki, a każdy rekord musi być unikalny.

Przykład w omawianej wcześniej bazie danych wypożyczalni samochodów każdy klient musi mieć unikalny zestaw danych. Idealna krotka spełniająca ten wymóg to imię i nazwisko, adres, … i PESEL ten ostatni element jest absolutnie niepowtarzalny i w przypadku, kiedy przy normalizacji usuniemy IdKlienta (klucz) to dalej będzie to niepowtarzalny rekord.

- 2NF

Aby być w regule 2NF, dane muszą najpierw dotyczyć wszystkich wymagań 1NF. Następnie dane muszą mieć tylko jeden klucz podstawowy. Aby oddzielić dane i mieć tylko jeden klucz podstawowy, wszystkie podzbiory danych, które można umieścić w wielu wierszach, należy umieścić w osobnych tabelach. Następnie można tworzyć relacje za pomocą nowych etykiet kluczy obcych.

Przykład w naszej bazie wypożyczalni samochodów główny klucz to Id Wypożyczenie (centrum gwiazdy). Do każdego wypożyczenia dodasz Klienta bez jego klucza co oznacza, że właśnie utworzono relację z obcym kluczem. W jednym rekordzie (krotce) umieszczono zestaw dwóch tabel bez konieczności zadawania rozbudowanego pytania SQL

- 3NF

Aby dane znalazły się w regule 3NF, muszą najpierw spełniać wszystkie wymagania 2NF. Następnie dane w tabeli muszą być zależne tylko od klucza podstawowego. Jeśli klucz podstawowy zostanie zmieniony, wszystkie dane, na które ma to wpływ, należy umieścić w nowej tabeli.

Przykład nasza baza danych wypożyczalni wymaga konieczności pogrupowania ze względu np. na samochody spełniające normę poniżej Euro3 i powyżej Euro3 a jedyne czym dysponujemy to modele samochodów. W tym przypadku musimy zmienić nasz klucz podstawowy tj. Id Klient i utworzyć nowe tabele z podziałem, który nas interesuje do dalszych obliczeń.

Tak przygotowana baza danych może (a raczej powinna) podlegać kolejnym koniecznym modyfikacjom, które zostaną tutaj jedynie wymienione:

- Czyszczenie danych np. usuwanie danych powtarzających się – Data clearing

- Uzupełnianie wartości brakujących – Filling missing values

- Usuwanie wartości mocno odstających – ewidentne błędy przypadkowe – Remove outliers

- Dostosowanie danych – Data transformation

- Usuniecie zbędnych danych – Data reduction

Skalowanie, klasyfikacja danych

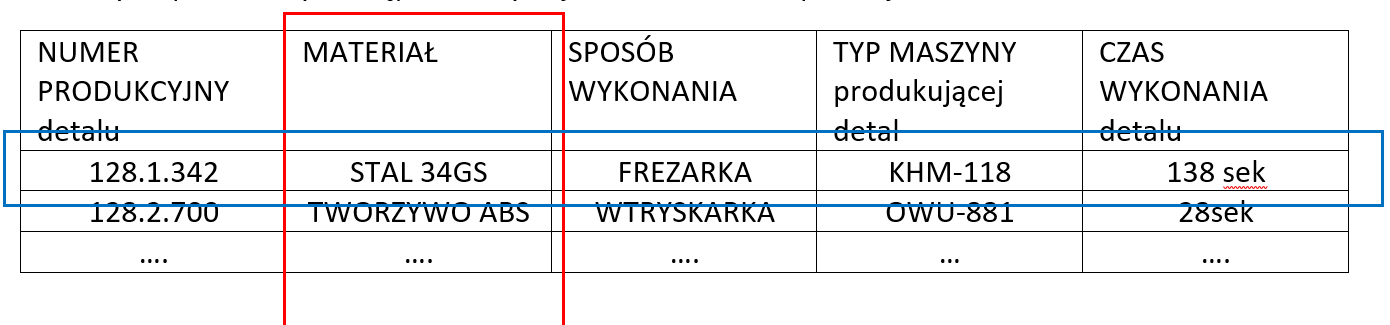

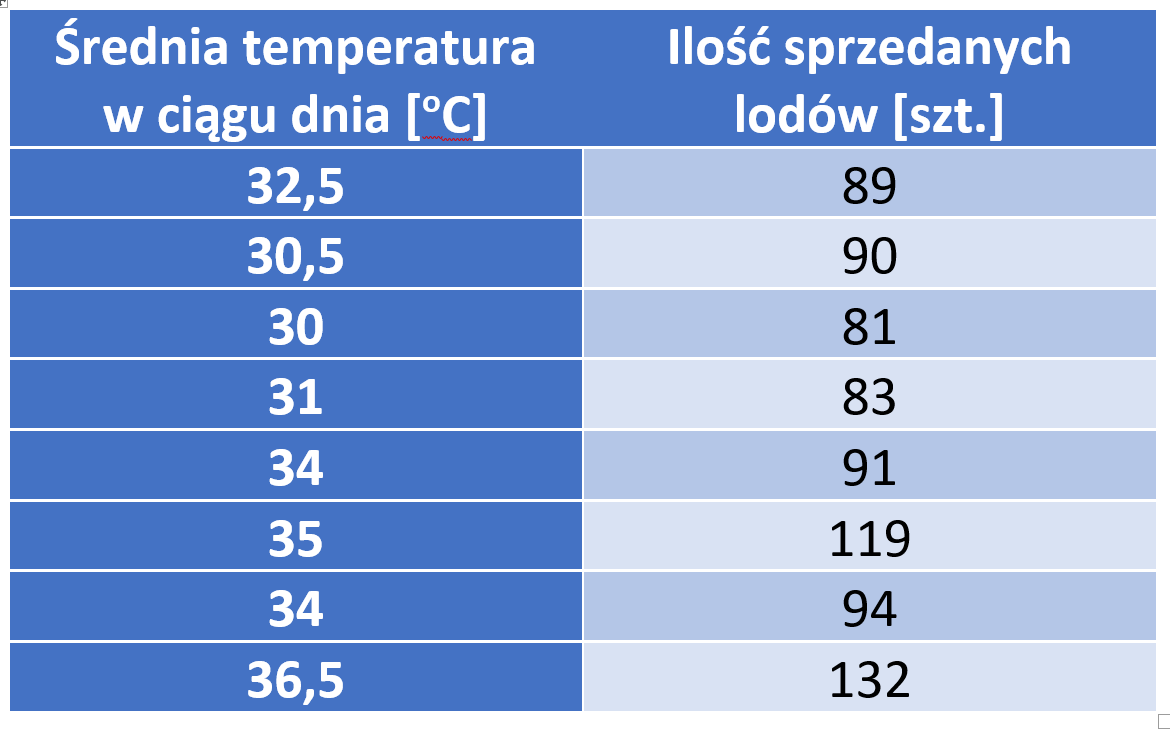

Załóżmy ze posiadamy dostęp do danych jak w zestawieniu poniżej

Nasz cel to stworzenie algorytmu, który zoptymalizuje produkcję wektory to nasze kolumny instancje/argumenty to wiersze. Wywołując jeden z elementów argumentu mamy dostęp do wielu elementów z różnych kolumn. To oznacza, że możemy utworzyć wiele odwzorowań y=f(x) w zależności od tego jakimi zbiorami modeli chcemy dysponować.

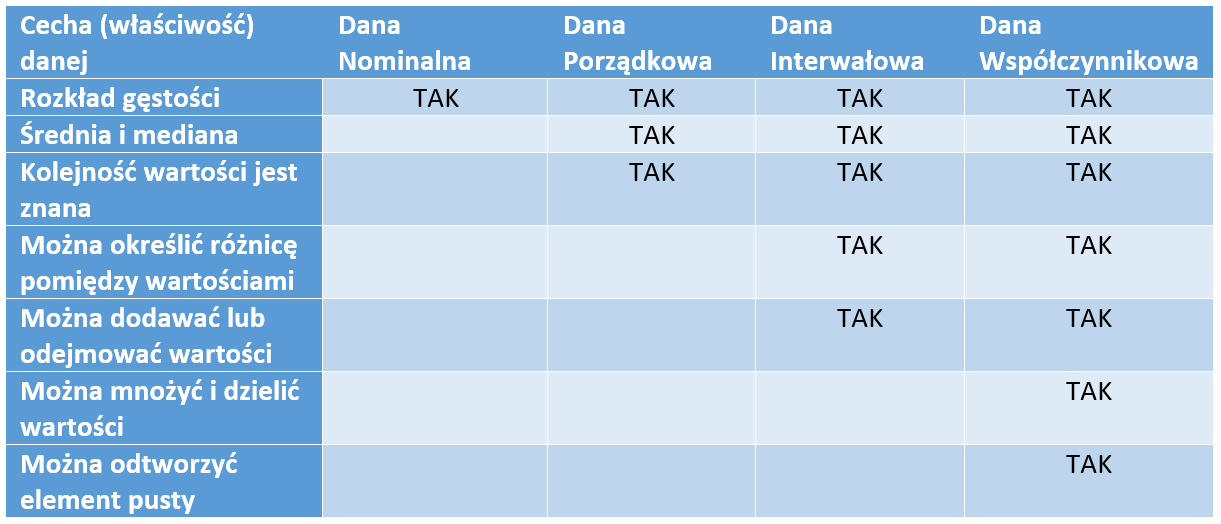

To oznacza również, jak bardzo różnie możemy dobrać wartości atrybutów i jak różne zestawy zależności możemy uzyskać. Na przykład numer detalu to kombinacja liczbowa, maszyna to tekst, materiał to tekst i liczba lub kombinacje tych dwóch. Aby lepiej zrozumieć typy wartości, przyjrzyjmy się poniższym definicjom:

- Dane nominalne (jakościowe) – składają się z danych, które wzajemnie się wykluczają i nie są uporządkowane. Przykłady: kolor oczu, stan cywilny, rodzaj posiadanego samochodu itd. w naszym przykładzie to – sposób wykonania.

- Dane porządkowe – odpowiadają kategoriom, w których porządek ma znaczenie, ale nie różnica między wartościami, takimi jak poziom bólu, oceny z listów uczniów, ocena jakości obsługi, oceny filmów. Daną porządkową jest np. numer detalu w tabeli powyżej

- Dane interwałowe (przedziałowe , równomierne) – składają się z danych, w których różnica między dwiema wartościami osiąga wartości z przedziału, ale nie ma pojęcia miejsca pustego, na przykład standaryzowany wyniki egzaminu, temperatura w stopniach Fahrenheita lub jak w naszym przykładzie czas produkcji detalu. Czas produkcji za ten sam detal będzie oscylował wokół jakiejś średniej wytwarzania będzie zawsze większy od zera i osiągał wartość X, ale wykonanie detalu nie może być polem pustym.

- Dane współczynnika (współczynnikowe, ilorazowe) – mają wszystkie właściwości zmiennej interwałowej, a także jasną definicja odwzorowania, charakteryzuje się stałymi stosunkami i bezwzględnym zerem, np. gdy zmienna argumentu jest pusta, to zmienna funkcji będzie brakująca, ale znając model będzie możliwość odwzorowania na podstawie innych pełnych danych zestawu. Zmienne takie jak ceny akcji, tygodniowe wydatki na żywność są zmiennymi proporcjonalnymi.

Zatem skalowanie to w przypadku uczenia maszynowego to nie tylko efekt miary np. km/h, temperatura, ale także typ danej w kontekście składni i jej elementów cyfrowych i/lub tekstowych. Dla przejrzystości zagadnienia poniższe zestawienie ułatwia ocenę typu danej

Przy czym dane nominalne i porządkowe odpowiadają wartościom dyskretnym, natomiast dane interwałowe (przedziału) i dane współczynnikowe mogą również odpowiadać wartościom ciągłym.

Należy przy tym zauważyć, że w uczeniu nadzorowanym skalowanie pomiaru i wartości atrybutów, które chcemy przewidzieć, dyktuje rodzaj algorytmu maszynowego, którego można użyć. Na przykład przewidywanie wartości dyskretnych z ograniczonego zbioru. Lista danych przyjmowana przez konkretny algorytm nazywana jest klasyfikacją i można ją uzyskać za pomocą drzew decyzyjnych, dla elementów dyskretnych, natomiast dla przewidywania wartości ciągłych (np. skala temperatury) nazywane są regresją, którą można osiągnąć za pomocą drzew modelowych lub modeli.

Zestaw (zbiór) danych

Skategoryzowanie danych to tylko krok w eksploracji danych. Następnym krokiem, zagadnieniem jest sprawdzenie, skąd pochodzą dane. Gromadzone dane mogą być bardzo niezorganizowane i w bardzo różnych formatach, co jest typowym wynikiem odczytu (zrzutu) z bazy/baz/tabel danych, Internetu, systemu plików lub innych dokumentów. Większość narzędzi do uczenia maszynowego wymaga prezentacji danych w określonym formacie w celu wygenerowania właściwego wyniku. Mamy dwie możliwości: obserwować dane z istniejących źródeł lub generować dane za pomocą ankiet, symulacji i eksperymentów. Każda z tych metod ma za zadanie zebranie i sformatowanie właściwych danych do właściwego algorytmu.

Wyszukiwanie i/lub obserwacja danych

Jak wspomniano wcześnie głównym źródłem to strony WWW i dostęp do danych jak danych GUS jak zbiory danych treningowych dostępnych poprzez Internet W tym przypadku najistotniejsza jest ich wiarygodność Główną wadą gromadzonych danych jest to, że gromadzenie ich wymaga czasu i przestrzeni. Ponadto te dane obejmują tylko to, co się wydarzyło; na przykład intencje i wewnętrzne i zewnętrzne motywacje nie są gromadzone. Wreszcie takie dane mogą być zaszumione, niekompletne, niespójne, a nawet może się z czasem zmienić. Inną opcją jest zbieranie pomiarów z czujników takich jak bezwładnościowe i lokalizacyjne, czujniki w urządzeniach mobilnych, czujniki środowiskowe i klucz do monitorowania agentów oprogramowania wskaźniki efektywności. Ten typ danych to są najcenniejsze zbiory. Dane ruchowe operatorów, dane środowiskowe, które wraz z połączeniem z bazami danych zakładów przemysłowych umożliwiają wykrycie niezliczonej ilości korelacji i zastosowań ML oraz AI.

Tworzenie własnych zbiorów danych

Alternatywnym podejściem jest wygenerowanie danych, na przykład za pomocą ankiety. W projektowaniu ankiet musimy zwrócić uwagę na próbkowanie danych; czyli kim są respondenci biorący udział w ankiecie. Pozyskujemy dane tylko od tych respondentów, którzy są dostępni i chętni do odpowiedzi. Respondenci mogą również udzielić odpowiedzi, które są zgodne z ich obrazem siebie i oczekiwaniami badacza.

Alternatywnie dane mogą być zbierane za pomocą symulacji, w których ekspert dziedzinowy określa model zachowania użytkowników na poziomie mikro. Na przykład symulacja tłumu wymaga określenia, jak różne typy użytkowników będą się zachowywać w tłumie. Niektóre przykłady to podążanie za tłumem, szukanie ucieczki i tak dalej. Symulację można następnie przeprowadzić w różnych warunkach, aby zobaczyć, co się stanie. Symulacje są odpowiednie do badania zjawisk makro i zachowań emergentnych, jednak zazwyczaj trudno je zweryfikować empirycznie. Co więcej, mozna projektować eksperymenty, aby dokładnie objąć wszystkie możliwe wyniki, w których wszystkie zmienne są stałe i manipulować tylko jedną zmienną na raz. Jest to najbardziej kosztowne podejście, ale zazwyczaj zapewnia najlepszą jakość.

Uzupełnianie brakujących wartości

Algorytmy uczenia maszynowego generalnie nie działają dobrze z brakującymi wartościami. Rzadko spotykanymi wyjątkami są drzewa decyzyjne, klasyfikator Naive Bayes i niektóre algorytmy uczące się na podstawie reguł. To jest bardzo ważne, aby zrozumieć i przeanalizować zbiór pod katem pustych pól, dlaczego brakuje wartości. Może brakować z powodu wielu przyczyn, takie jak błąd przypadkowy, błąd systematyczny i szum czujnika. Najważniejsze jest by umieć zidentyfikować w zbiorze brakujące dane. Istnieje wiele sposobów radzenia sobie z brakującymi wartościami, jak pokazano w poniższej liście.

- Usunięcie instancji – jeśli jest wystarczająco dużo danych i tylko kilka nieistotnych braków To w przypadku wystąpienia niektórych braków danych można bezpiecznie usunąć te wystąpienia.

- Usunięcie atrybutu – usunięcie atrybutu ma sens, gdy większość brakujących wartości to wartości stałe lub atrybut jest silnie skorelowany z kolejnym atrybutem.

- Przypisanie specjalnej wartości – może się zdarzyć, że brakuje wartości z ważnych powodów, np. wartość jest poza zakresem, wartość atrybutu dyskretnego nie jest zdefiniowana oraz gdy wartość jest niemożliwa do uzyskania lub zmierzenia. Na przykład, jeśli dana osoba nigdy nie oceniła filmu lub jego ocena w tym filmie nie istnieje.

- Wyznaczenie średniej wartości atrybutu – jeśli mamy ograniczoną liczbę wystąpień, a każde usunięcie instancji lub atrybutów stanowi poważne zubożenie zbioru to w takim przypadku możemy oszacować brakujące wartości, przypisując średnią wartość atrybutu.

- Prognozowanie wartość z na postawie innych atrybutów – można próbować przewidywać wartość na podstawie poprzednich wpisów, jeśli atrybut posiada zależności zbieżne korelacyjne

Wartości może brakować z wielu powodów, dlatego ważne jest, aby zrozumieć, dlaczego brakuje wartości, i jaki jest powód, że jest ona nieobecna lub uszkodzona.

Czyszczenie danych

Czyszczenie danych, znane również jako szorowanie danych, to proces składający się z następujących kroków:

- Identyfikacja niedokładnych, niekompletnych, nieistotnych lub uszkodzonych danych w celu usunięcia ich z dalszego przetwarzania

- Parsowanie danych (składanie w określone zbiory) poprzez wydobywanie interesujących informacji lub sprawdzanie, czy ciąg danych ma akceptowalny format

- Przekształcenie danych do wspólnego formatu kodowania, na przykład UTF-8 lub int32, skali czasu lub znormalizowanego zakresu

- Przekształcenie danych we wspólny schemat danych; na przykład, jeśli zbieramy pomiary temperatury z różnych typów czujników, możemy chcieć, aby miały taką samą strukturę np. taki sam element sondy pomiarowej przykładowo tylko sonda PT100 a nie np. Pt100 i Pt 1000.

Usuwanie wartości odstających

Wartości odstające w danych to wartości, które różnią się od innych wartości w serii i wpływają w dużym stopniu na wszystkie metody uczenia się. Mogą to być wartości ekstremalne, które można wykryć za pomocą przedziałów ufności i usunąć za pomocą progu. Najlepszym podejściem jest wizualizacja danych i sprawdzenie wizualizacji w celu wykrycia nieprawidłowości. Dlaczego to takie istotne? Załóżmy, że obrabiarka frezuje dany element w określonym czasie jednakże w trakcie zbierania pomiarów uszkodzeniu uległ frez w wyniku czego dany element został wykonany (nie istotne czy źle czy dobrze) w innym niż typowy czas. Użycie tego zbioru jako danych treningowych bez wyłapania anomalii będzie stanowić poważny błąd. Taki element należy wykluczyć ponieważ może mieć wpływ na wyłapanie anomalii w przyszłości.

Transformacja (dostosowywanie) danych

Techniki transformacji danych dostosowują zbiór danych do formatu, który jest używany przez uczenie maszynowe. Algorytm oczekuje jako danych wejściowych takich danych które jest w stanie samodzielnie przetwarzać. Jest to szczególnie istotne w przypadku algorytmów zastosowanych do działań w czasie rzeczywistym, gdzie np. algorytm predykcji ma służyć w podejmowaniu decyzji dla regulacji automatyki sterującej. Nazywa się to również przetwarzaniem danych lub przepychaniem danych.

Transformacja poosiowa (przesuwanie danych po osi lub wektorze)

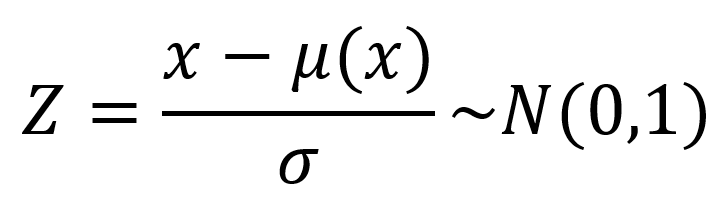

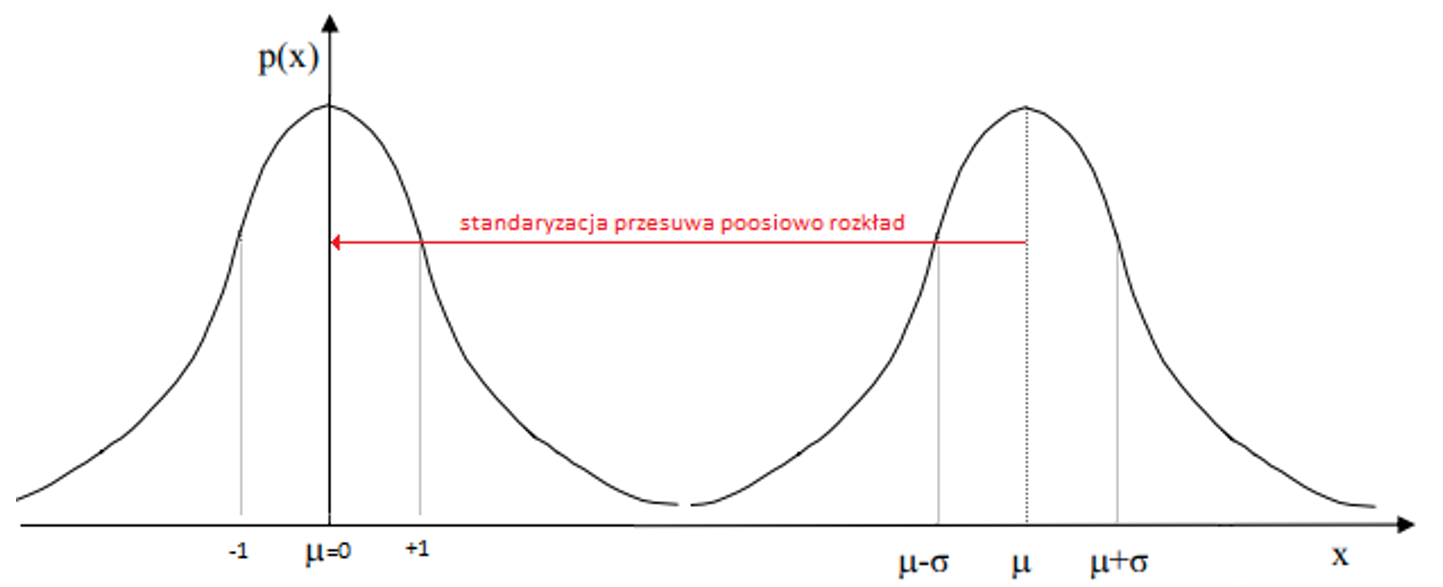

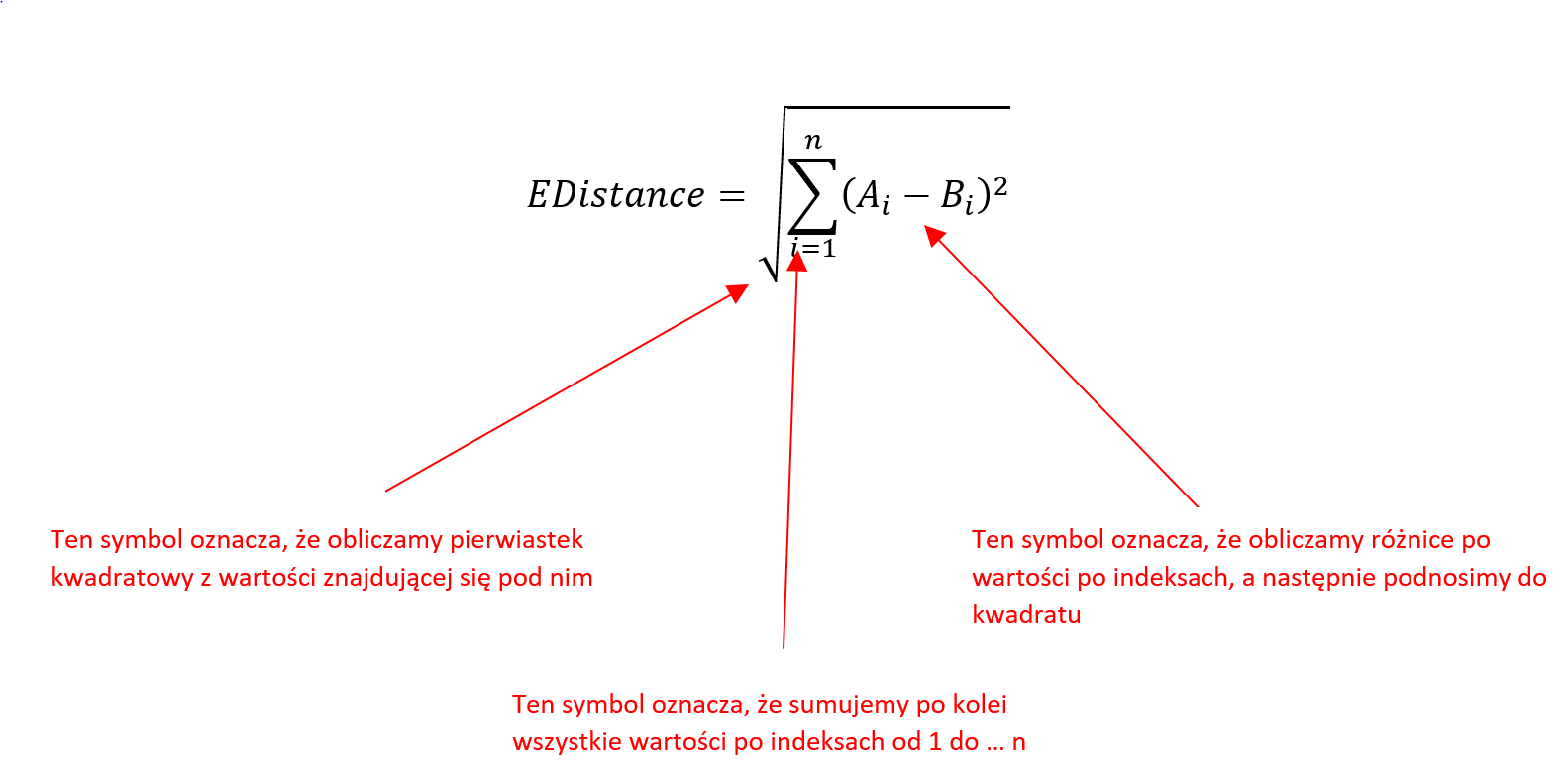

Najbardziej znana jest standaryzacja rozkładu Gaussa, która zakłada, że w celu wykonania stosownych obliczeń sprowadzamy dowolny rozkład normalny do rozkładu standaryzowanego w taki sposób, aby średnia wartość wynosiła µ=0, a odchylenie σ=1. Transformacje wykonujemy z zastosowaniem poniższej zależności.

gdzie μ- średnia rozkładu

ϭ-odchylenie standardowe

Wiele zestawów narzędzi do uczenia maszynowego automatycznie normalizuje i standaryzuje dane.

Przykład obliczeń: mamy rozkład gdzie μ=7 a ϭ=6 → N(7,6). Znaleźć zmienną „Z” dla rozkładu standaryzowanego przy danym X=4 → Z=(4-7)/6=-1/3 ~ N(0,1).

Dyskretyzacja

Ostatnią omawiana techniką transformacji jest dyskretyzacja, która dzieli zakres ciągłego atrybutu na przedziały. Dlaczego powinniśmy się tym przejmować? Niektóre algorytmy, takie jak drzewa decyzyjne i Naive Bayes preferują atrybuty dyskretne.

Najczęstsze sposoby wyboru interwałów (przedziałów) są następujące:

- Równa szerokość – przedział zmiennych ciągłych jest podzielony na k przedziałów o równej szerokości

- Równa częstotliwość – przypuśćmy, że istnieje N instancji, każdy z k przedziałów zawiera w przybliżeniu N lub k instancji

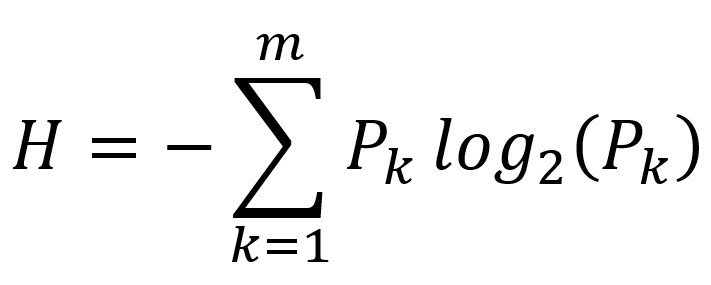

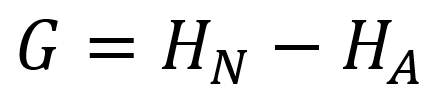

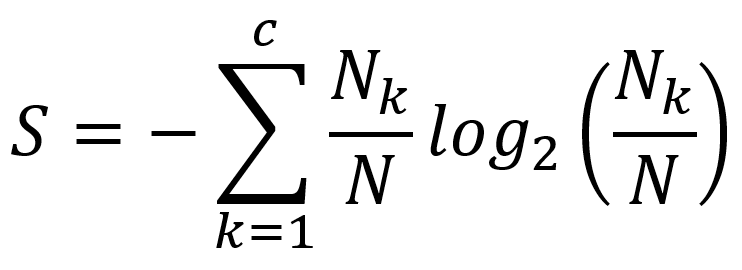

- Minimalna entropia – to podejście rekurencyjnie dzieli interwały, aż entropia, która mierzy nieuporządkowanie, zmniejszy się bardziej niż wzrost entropii wprowadzony przez podział interwałowy.

Dwie pierwsze metody wymagają od nas określenia liczby interwałów, podczas gdy ostatnia metoda automatycznie ustawia liczbę interwałów; wymaga jednak zmiennej klas, co oznacza, że nie będzie działać w przypadku nienadzorowanych zadań uczenia maszynowego.

Redukcja danych

Redukcja danych dotyczy wielu atrybutów i instancji. Liczba atrybutów odpowiada liczbie wymiarów w naszym zbiorze danych. Wymiary o niskiej mocy predykcyjnej mają bardzo mały wkład w ogólny model i powodują wiele szkód. Na przykład atrybut o losowych wartościach może wprowadzać pewne losowe wzorce, które zostaną odebrane przez algorytm uczenia maszynowego. Może się zdarzyć, że dane zawierają dużą liczbę braków danych, przy czym musimy znaleźć przyczynę braków w dużej liczbie i na tej podstawie może je wypełnić jakąś alternatywną wartością lub imputować lub całkowicie usunąć atrybut. Jeśli brakuje 40% lub więcej wartości, może być wskazane usunięcie takich atrybutów, ponieważ wpłynie to na wydajność modelu.

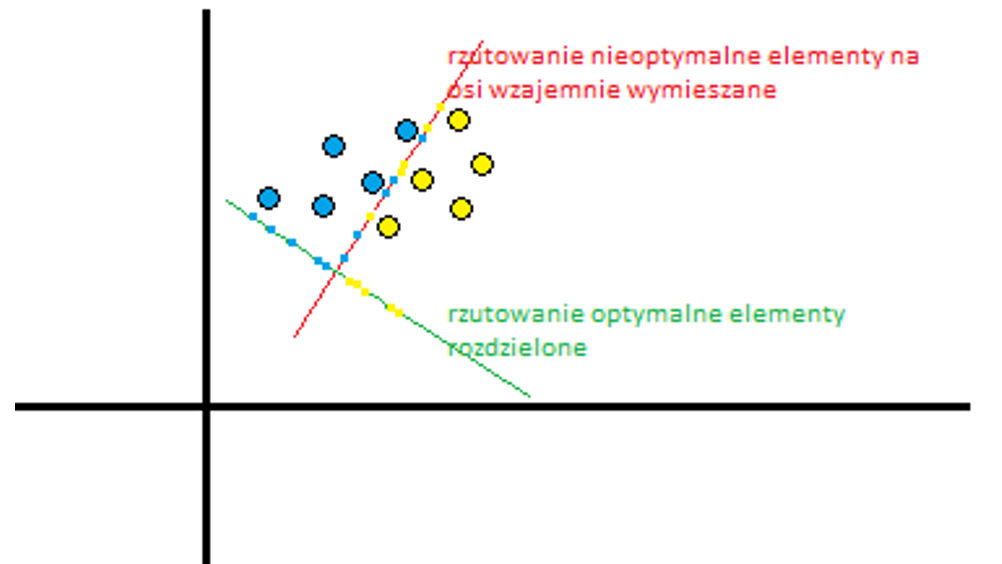

Drugim czynnikiem jest wariancja, gdzie zmienna stała może mieć niską wariancję, co oznacza, że dane są bardzo blisko siebie lub nie ma dużej zmienności w danych. Aby poradzić sobie z tym problemem, pierwszy zestaw technik usuwa takie atrybuty i wybiera te najbardziej obiecujące. Proces ten jest znany jako selekcja cech lub selekcji atrybutów i obejmuje metody takie jak ReliefF, zysk informacji i indeks Giniego. Metody te koncentrują się głównie na atrybutach dyskretnych. Inny zestaw narzędzi, skoncentrowany na ciągłych atrybutach, przekształca zbiór danych z oryginalnych wymiarów do przestrzeni o niższych wymiarach. Na przykład, jeśli mamy zbiór punktów w przestrzeni trójwymiarowej, możemy wykonać rzut na przestrzeń dwuwymiarową. Część informacji jest tracona, ale w sytuacji, gdy trzeci wymiar jest nieistotny, my nie tracimy

dużo, ponieważ struktura danych i relacje są prawie doskonale zachowane. Można to wykonać następującymi metodami:

- Rozkład według wartości osobliwych (SVD)

- Analiza głównych składników (PCA)

- Eliminacja funkcji wstecz/do przodu

- Analiza czynników

- Liniowa analiza dyskryminacyjna (LDA)

- Autokodery sieci neuronowych

Kolejny problem związany z redukcją danych jest uzależnienie od zbyt dużej liczby przypadków. Na przykład mogą być duplikatami lub pochodzić z bardzo gęstego strumienia danych. Główną ideą jest wybranie podzbioru instancji w taki sposób, aby dystrybucja wybranych danych nadal przypominała pierwotną dystrybucję danych, a co ważniejsze, obserwowany proces. Techniki mające na celu zmniejszenie liczby wystąpień obejmują losowe próbkowanie danych, stratyfikację i inne. Po przygotowaniu danych możemy przystąpić do analizy i modelowania danych.

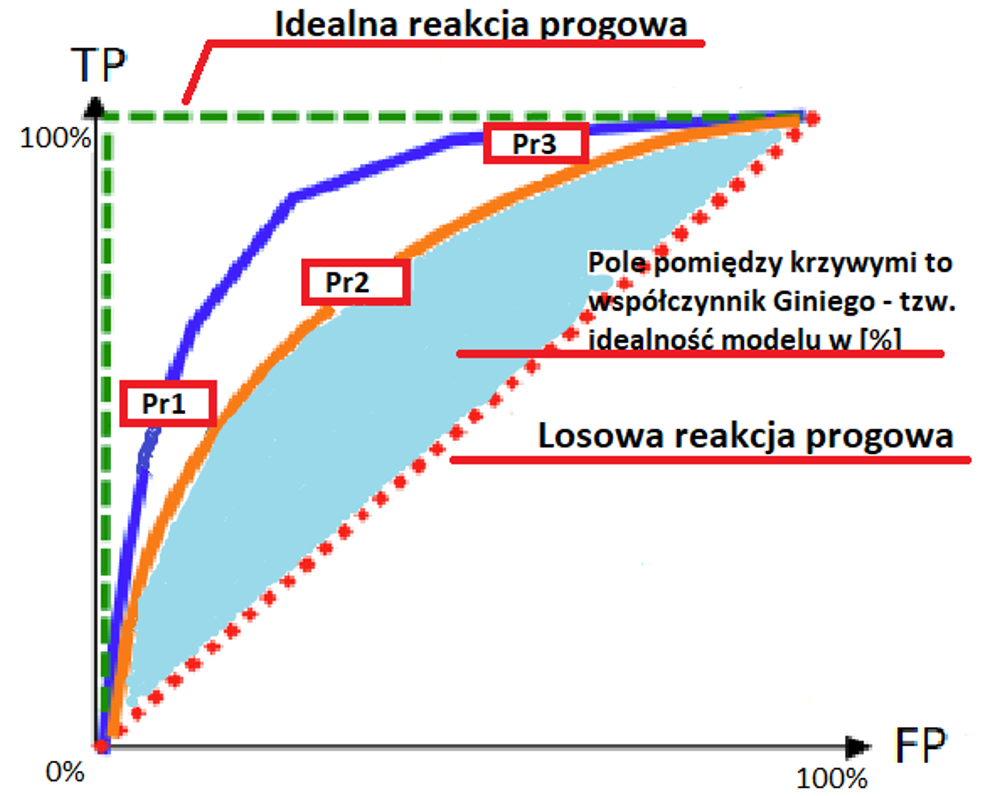

Klasyfikacja

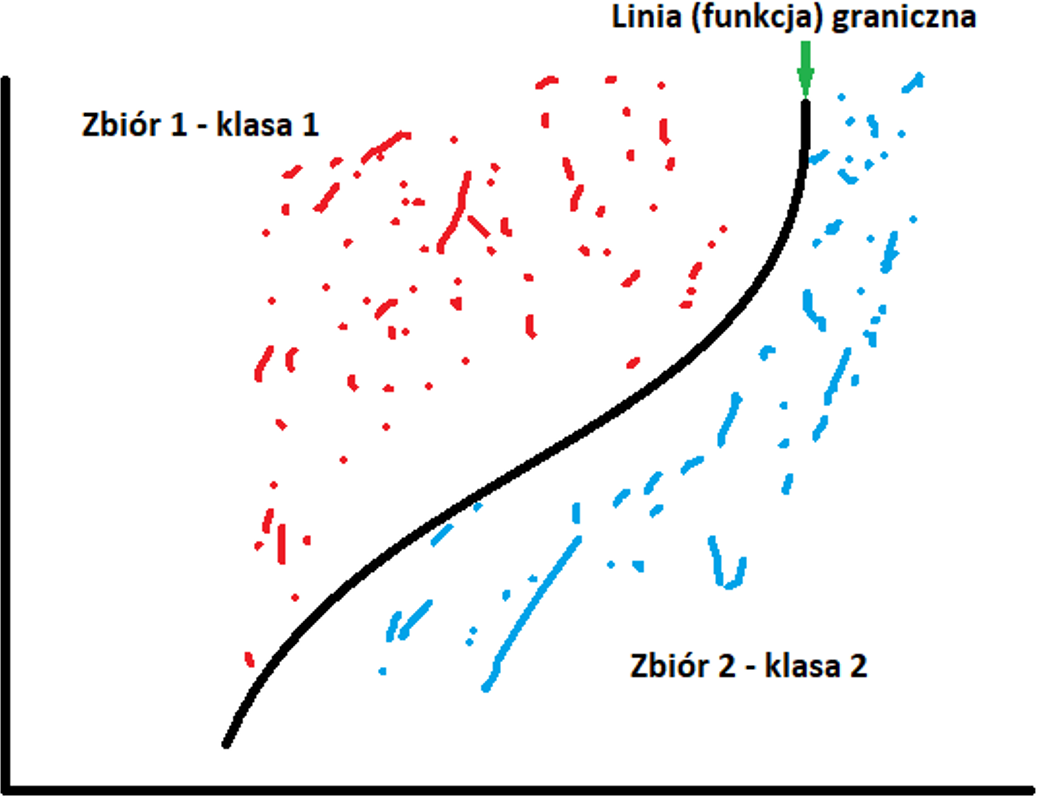

Najprościej o klasyfikacji możemy powiedzieć jako o technice określania, do której klasy należy jednostka zależna, na podstawie co najmniej jednej zmiennej niezależnej. Ilustruje to poniższy rysunek.

Klasyfikację można zastosować, gdy mamy do czynienia z klasą dyskretną, której celem jest przewidzenie jednej z wzajemnie wykluczających się wartości w zmiennej docelowej. Przykładem może być ocena kredytowa, gdzie ostateczną prognozą jest to, czy danej osobie można udzielić kredyt, czy nie. Do najpopularniejszych algorytmów klasyfikujących należą drzewa decyzyjne, klasyfikatory Naive Bayes, maszyny SVM, sieci neuronowe czy uczenie zespolone.

Drzewa decyzyjne

Metoda drzewa decyzyjnego to koncepcja tworzy drzewo klasyfikacyjne, w którym każdy węzeł odpowiada jednemu z atrybutów, krawędzie odpowiadają możliwej wartości (lub przedziałom) atrybutu, z którego pochodzi węzeł; a każdy liść odpowiada etykiecie klasy i stanowi wynik decyzji. Drzewo decyzyjne może służyć do wizualnego i jawnego reprezentowania modelu predykcyjnego, co czyni go bardzo przejrzystym klasyfikatorem. Godne uwagi algorytmy to ID3 i C4.5, chociaż istnieje wiele alternatywnych implementacji i ulepszeń (na przykład J48 w Weka).

Przykład graficzny prostego drzewa decyzyjnego czy badana osoba nabyła prawa emerytalne. Dane wejściowe „płeć”; „wiek”

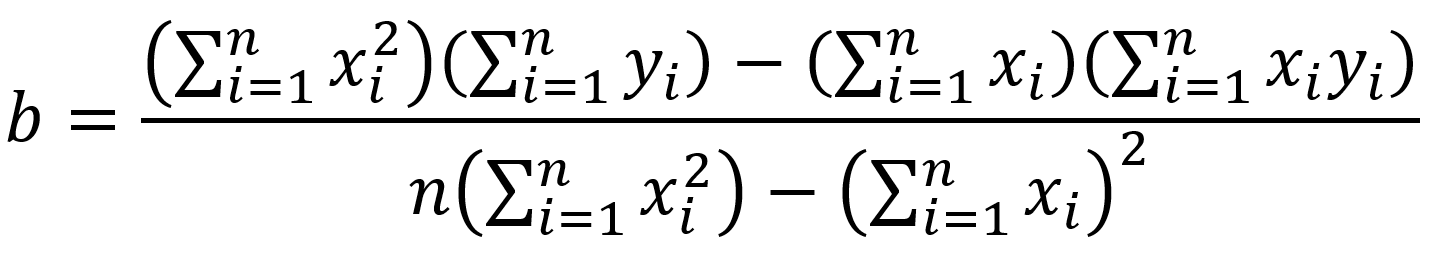

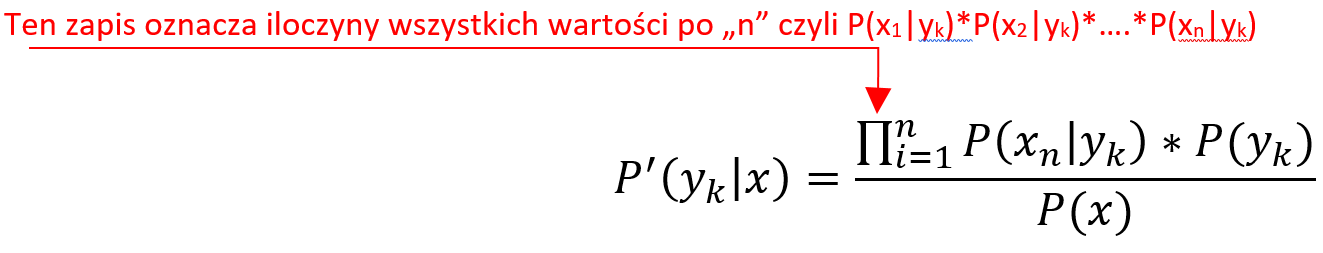

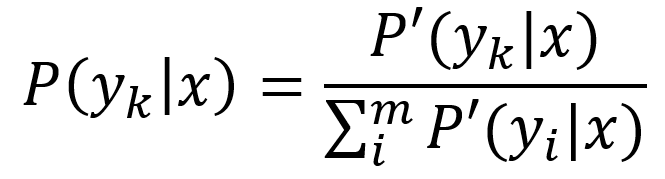

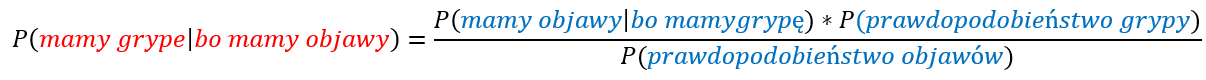

Klasyfikatory proabilistyczne

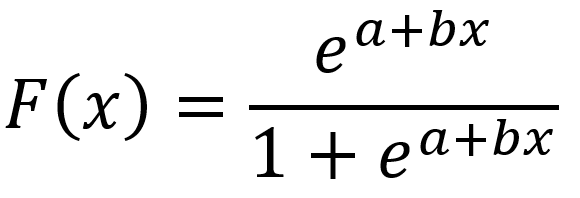

O klasyfikatorze probabilistycznym mówimy wtedy, kiedy mając zestaw wartości atrybutów, klasyfikator probabilistyczny jest w stanie przewidzieć rozkład w zestawie klas, a nie w dokładnej klasie. Klasyfikacja probabilistyczna oznacza, że model użyty do klasyfikacji jest modelem probabilistycznym, w szczególności modele te mogą podawać prawdopodobieństwo wystąpienia instancji należącej do klasy pozytywnej lub negatywnej. Następnie do nas należy decyzja, czy instancja jest dodatnia, czy ujemna na podstawie prawdopodobieństw podanych przez model. Dwie powszechnie stosowane formy modeli probabilistycznych to:

- Modele generatywne: Jeśli x oznacza instancję (argument), a y oznacza etykietę, to w modelach generatywnych uczymy się łącznego rozkładu względem x i y, P(x, y) lub równoważnie P(x|y) i P(y). Rozpoczyna się od założenia rozkładu parametrycznego dla P(x, y) (lub P(x|y) i P(y)) a następnie uczenia parametrów przy użyciu danych uczących. Modele te nazywane są generatywnymi, ponieważ po poznaniu parametrów modele te pozwalają nam „generować” z nich nowe punkty danych poprzez próbkowanie. Przykładem takiego modelu klasyfikacji jest Naive Bayes.

- Modele dyskryminacyjne: Jeśli x oznacza instancję (argument), a y oznacza etykietę, to w modelach dyskryminacyjnych uczymy się warunkowego rozkładu na y przy danym x, P(y|x). Rozpoczyna się od założenia rozkładu parametrycznego dla P(y|x), a następnie uczenia parametrów przy użyciu danych uczących. Modele te nazywane są rozróżniającymi, ponieważ po poznaniu parametrów modele te pozwalają nam jedynie „rozróżniać” klasy dla danej instancji na podstawie prawdopodobieństw, które zapewniają. Modele te nie umożliwiają generowania nowych punktów danych, takich jak modele generatywne. Przykładem takiego modelu klasyfikacji jest regresja logistyczna.

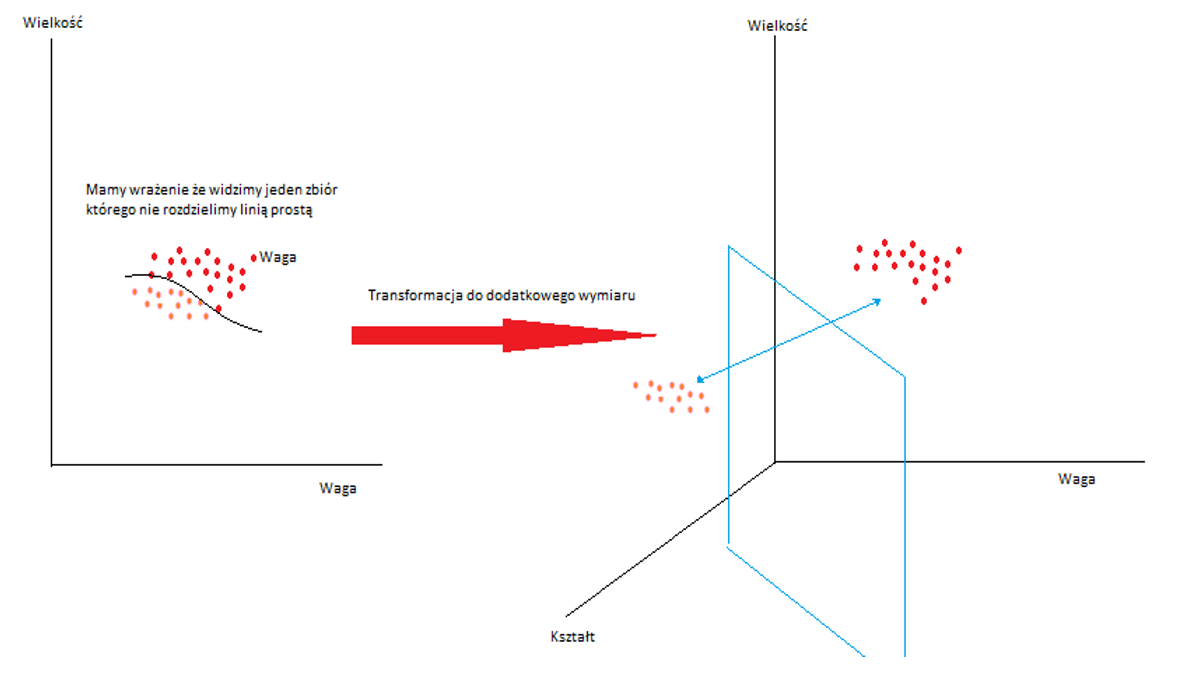

Metoda Kernel (metoda/funkcja jądra) i SVM

Każdy model liniowy można przekształcić w model nieliniowy, stosując manipulację jądra do modelu — zastępując jego cechy (predyktory) funkcją jądra. Innymi słowy, jądro pośrednio przekształca nasz zbiór danych w wyższe wymiary. Sztuczka z jądrem wykorzystuje fakt, że często łatwiej jest rozdzielić instancje w większej liczbie wymiarów. Funkcje jądra umożliwiają manipulowanie danymi jak by był rzutowany w przestrzeń wyższego wymiaru, operując na nim w jego pierwotnej przestrzeni. Żeby zrozumieć zagadnienia kernelowske trzeba najpierw omówić zagadnienie związane z pojęciem Support Vector Machine (SVM).

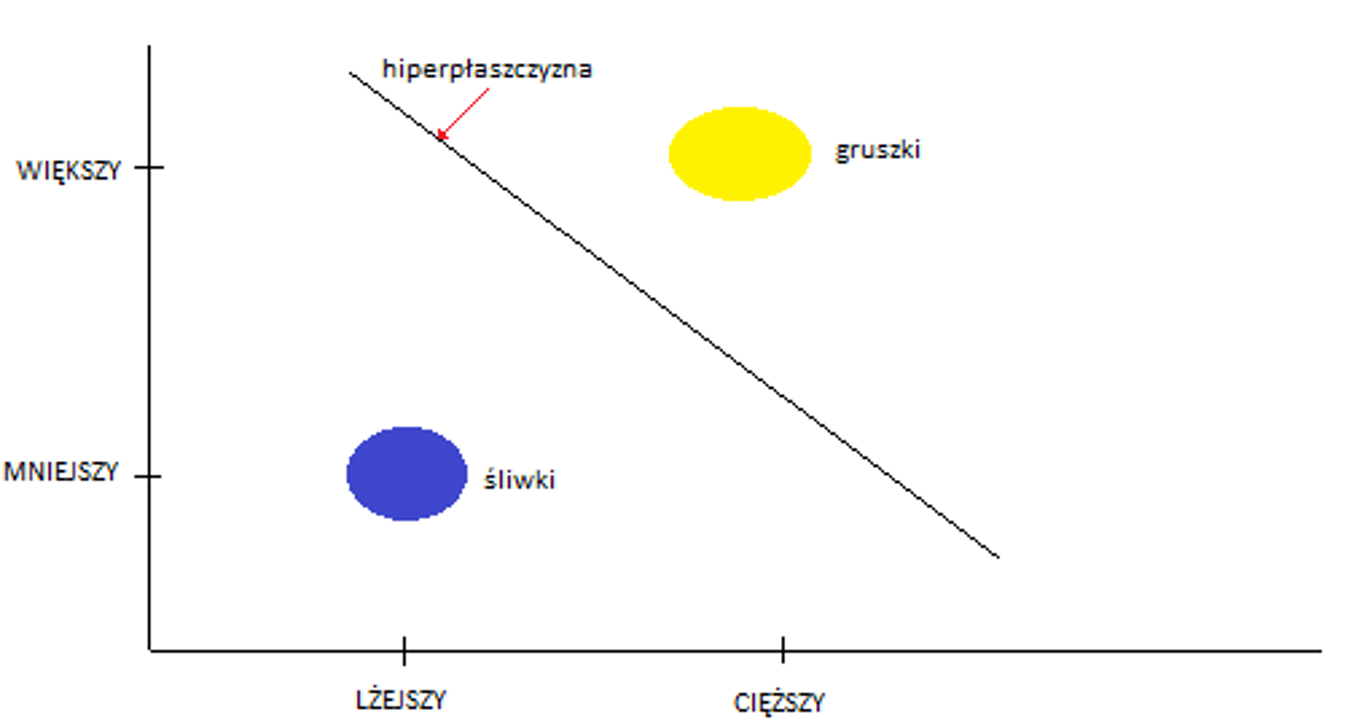

SVM to nadzorowane modele uczenia maszynowego które analizują dane w celu ich klasyfikacji (tutaj klasyfikację należy rozumieć pod kątem tego – „co należy do czego”). Jeśli spojrzymy na drzewo opisane w „Drzewa decyzyjne” to kobieta lat 61 jest sklasyfikowana jako emeryt. Jest to klasyfikacja niejako ustawiona „na sztywno”, inaczej będzie to wyglądało w przypadku klasyfikacji SVM. Dla zbiorów danych SVM to klasyfikator formalnie zdefiniowany jako rozdzielająca hiperpłaszczyzna. Hiperpłaszczyzna to podprzestrzeń o jeden wymiar mniej niż jej przestrzeń otoczenia, czyli przestrzeni, w której znajdują się badane zbiory. Jest klasyfikatorem, który reprezentuje dane uczące jako punkty w przestrzeni podzielone na kategorie przerwą jak najszerszą. Nowe punkty są następnie dodawane do przestrzeni poprzez przewidywanie, do której kategorii należą i do jakiej przestrzeni będą należeć.

Przykład: Podzieliśmy owoce z koszyka na dwie grupy – waga, kształt. Powiedzmy, że robiły to osoby z zawiązanymi oczami. Wyszły nam dwie grupy owoców i nie było to trudne do podziału, ponieważ, w koszyku były śliwki węgierki i gruszki klapsy.

Matematycznie miejsce w przestrzeni dwuwymiarowej (lub obiekt/klasa w przestrzeni) jest nieformalnie zdefiniowany jako element o współrzędnych (x, y, na osiach rzędnej i odciętej) i są to dane potrzebne do określenia dowolnego punktu (jak np. mniejszy i lżejszy oraz większy i cięższy) w tej przestrzeni. Rzeczywista przestrzeń otoczenia takiego obiektu różni się od przestrzeni matematycznej otaczającej obiekt matematyczny. Matematyczny obiekt jest abstrakcyjny i wynikający z matematyki opis też jest abstrakcyjny dla obiektu/rzeczy, który nie istnieje w danym czasie i miejscu rzeczywistym, ale raczej istnieje jako rodzaj idei lub abstrakcji. W omawianym przykładzie mówimy, że centroidy zbiorów i same zbiory są mocno skorelowane ze swoimi klasami, oraz, że nie występują elementy niejednoznaczne tj. takie które teoretycznie mogą należeć zarówno do jednego lub drugiego ze zbiorów. Dlaczego to takie istotne? Ponieważ dla SVM w takim przypadku hiperpłaszczyzna dla przestrzeni dwuwymiarowej jest jednowymiarową linią prostą oddzielającą te dwa zbiory z odpowiednim marginesem (z założenia jak najszerszym).

Inaczej mówiąc kwalifikacja zbioru (matematycznie) ulega znaczącemu uproszczeniu. Nie mamy przestrzeni dwóch zbiorów śliwka=f(x1, y1) oraz gruszka=f(x2, y2), ale prosty zapis rozdziału dwóch klas oddzielonych od siebie równaniem y=ax+b (równanie prostej na płaszczyźnie dwuwymiarowej) i pasa marginesu. Po fazie trenowania i przejściu do fazy testu, oznacza to uproszczenie kwalifikacji na podstawie tylko jednej danej(zmiennej) bo albo coś znajduje się z prawej strony nowej osi podziału albo z jej lewej strony lub albo nad nią, albo pod nią w zależności jak na to patrzymy. Na co powinniśmy jednak zwrócić szczególną uwagę to fakt, że w tym przypadku mamy brak losowości. Nawet z zawiązanymi oczami po prostu bardzo trudno o jakikolwiek błąd. Trzymając w ręku jeden wzorzec biorąc w drugą czy to śliwkę czy gruszkę bez problemu odróżnimy te dwa owoce. SVM uprościło nam proces decyzji. Bardziej szczegółowe wyjaśnienie opisano tutaj https://www.slideshare.net/saipuji1/support-vector-machine-and-implementation-using-weka

Powróćmy zatem do kwestii kernel czyli jądra. Rozważmy inną kwestie koszyka z owocami. Tym razem w koszyku są dwa gatunki jabłek. Niech będą to np. Ligol i Lobo. Te pierwsze powszechnie rozpoznawalne po dużej wielkości te drugie rozpoznawalne jako lekko stożkowate. W tym przypadku podział z zawiązanymi oczami nie jest taki oczywisty. Dlaczego? Ponieważ nasza rozróżnialność będzie obarczona dużym błędem a zbiory będą się wzajemnie przenikać. Nie znając bardziej szczegółowych cech każdy z tych owoców każde będzie dla nas po prostu jabłkiem. Przekształcany nasz zbór dwuwymiarowy do zbioru trójwymiarowego dodając nową cechę „kształt” jak poniżej

Widzimy, że zbiór widoczny od strony płaszczyzny jest dalej dwuwymiarowy, ale od strony nowej przestrzeni trójwymiarowej jest widoczna różnica zbiory są bardziej rozdzielne. Z definicji sztuczka kernel (kernel trick) jest opisana

K(x, y)=<f(x), f(y)>

gdzie K-funkcja Kernel od wskazanych zmiennych x, y w przestrzeni n wymiarowej

f-funkcje od x, y w przestrzeni m wymiarowej takiej, że m>n

W przypadku normalnych obliczeń, każda ze współrzędnych wymaga najpierw obliczeń funkcji f(x) oraz F(y) w nowej przestrzeni a następnie przemnożenie skalarnie (iloczyn skalarny) elementów w nowej przestrzeni. Otrzymany wynik jest skalarem co w praktyce oznacza, że do określenia poprawnego wyniku musimy powrócić do pierwotnej przestrzeni.

Jak to wygląda matematycznie – przykład bez kernel:

Mamy zbiór elementów X=(x1, x2) oraz elementów Y=(y1, y2), nowe funkcje będą zatem miały postać f(x)=(x1x1, x1x2, x2x1, x2x2) oraz f(y)-(y1y1, y1y2, y2y1, y2y2) czyli z dwóch mamy 4 wymiary. Liczbowo – niech x=(1, 2) oraz y=(4,5) będzie to odpowiednio

f(x)=(1, 2, 2, 4) oraz f(y)=(16, 20, 20, 25) zatem <f(x), f(y))>=(1*16+2*20+2*20+4*25)=196

Te same obliczenia w kernelem natomiast będą następujące:

K(x, y)=(<x, y>)2 podstawiając te same dane dla x oraz y mamy odpowiednio (1*4+2*5)^2=142=196

Podsumowując kernelem zwiększając przestrzeń o jeden raz więcej osiągamy ten sam wynik przy znacznie mniejszej ilości działań. Szczegóły na stronie https://www.quora.com/What-are-kernels-in-machine-learning-and-SVM-and-why-do-we-need-them/answer/Lili-Jiang?srid=oOgT

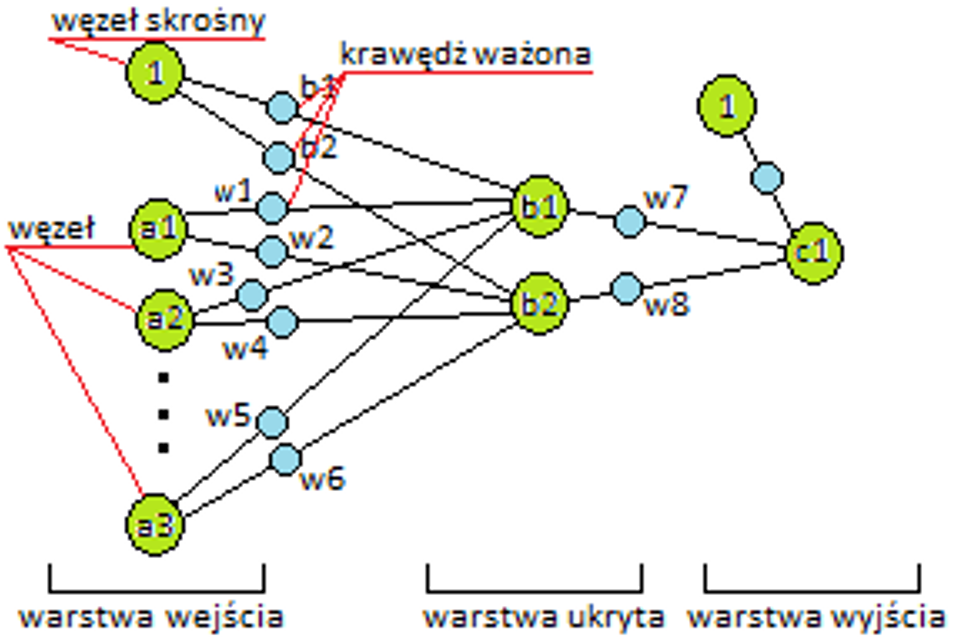

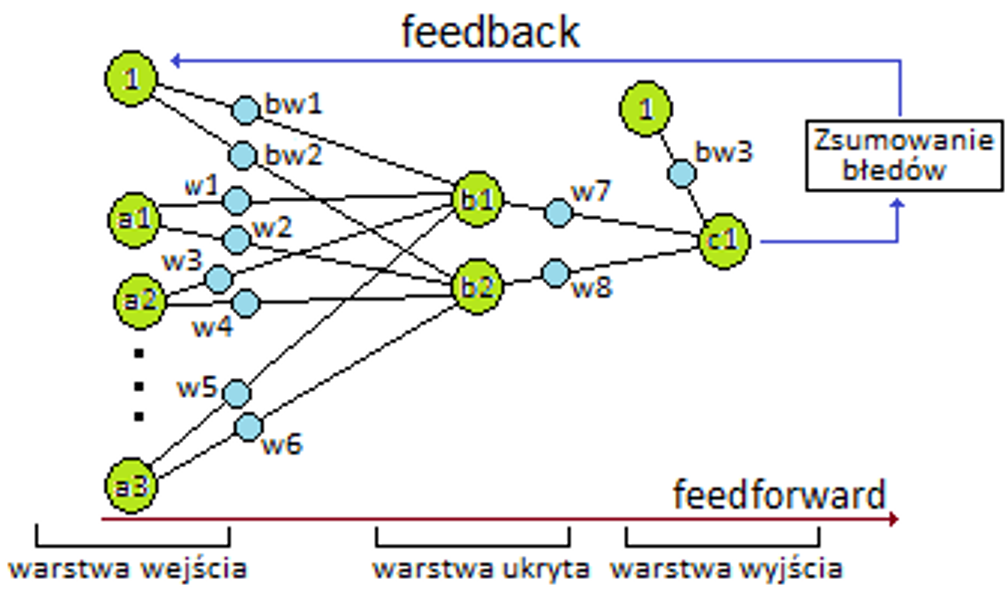

Sztuczne sieci neuronowe

Sztuczne sieci neuronowe są inspirowane strukturą biologicznych sieci neuronowych i są zdolne do uczenia maszynowego, a także rozpoznawania wzorców. Są powszechnie używane zarówno dla problemów regresji, jak i klasyfikacji, obejmujących szeroką gamę algorytmów i wariacje dla wszystkich rodzajów problemów. Niektóre popularne metody klasyfikacji to perceptron, ograniczona maszyna Boltzmanna (RBM) czy głębokie sieci neuronowe.

Metody zespołowe

Metody zespołowe składają się z zestawu różnych słabszych modeli w celu uzyskania lepszej wydajności predykcyjnej. Poszczególne modele są trenowane oddzielnie, a ich predykcje są następnie łączone w pewien sposób w celu uzyskania ogólnej prognozy. W związku z tym zestawy zawierają wiele sposobów modelowania danych, co powinno z założenia prowadzić do lepszych wyników. Jest to bardzo potężna klasa technik i jako taka jest bardzo popularna. Ta klasa obejmuje boosting, bagging, AdaBoost i losowy las. Główne różnice między nimi to rodzaj słabych uczniów, których należy łączyć, oraz sposoby ich łączenia.

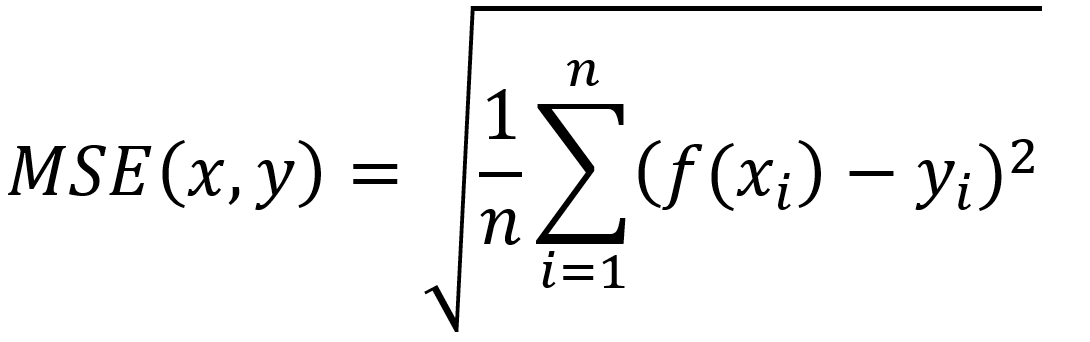

Metody oceniania klasyfikacyjne

W klasyfikacjach liczymy, ile razy klasyfikujemy coś na TAK lub NIE by dojść do celu i ostatecznej odpowiedzi jak dokładnie to zrobiliśmy. Dobrym przykładem jest np. gra w odgadywanie jaki mam zawód gdzie osoba pytająca dostaje tylko odpowiedź TAK lub NIE. Ostatecznie może udać się nam odgadnąć zwód prawidłowo, lub znacząco przybliżyć się do wiedzy co to za praca, albo się dowiedzieć że to osoba nie pracuje.

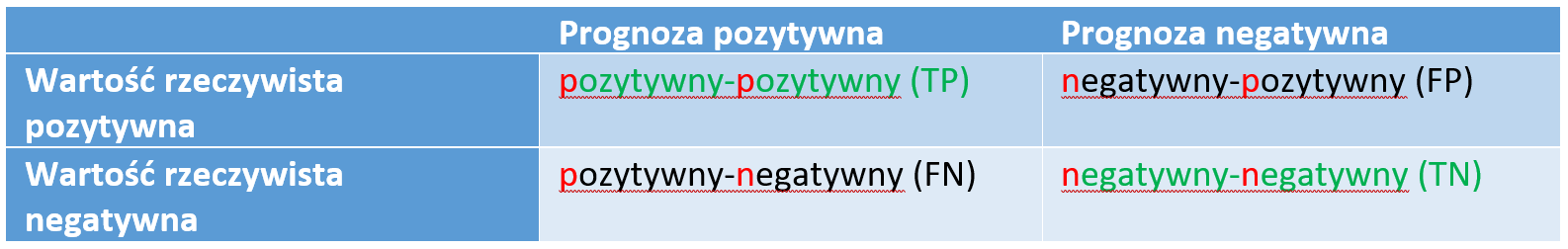

Klasyfikacja binarna

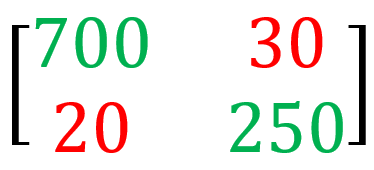

W metodach oceny klasyfikacji ten system jest nieco bardziej rozbudowany. Załóżmy, że istnieją dwie możliwe etykiety klasyfikacyjne: tak i nie w systemie gdzie porównujemy wartość prognozowaną z wartością otrzymaną w rzeczywistości. W odpowiedzi mamy cztery możliwe wyniki oceny, jak pokazano w poniższej tabeli czasami nazywanej macierzą błędów:

Stany zaznaczone na zielono zaliczamy do wyników właściwych pozostałe to fałszywe alarmy (chybienia). Podsumowując wyniki z tabeli otrzymujemy dwie podstawowe miary klasyfikacji:

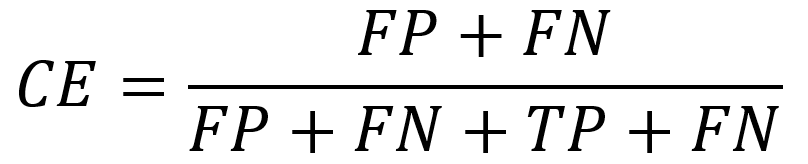

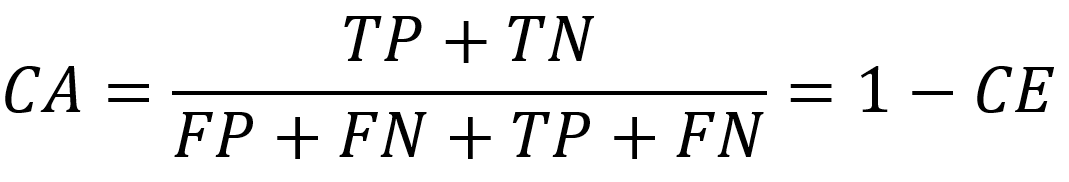

- Błąd klasyfikacji

- Dokładność klasyfikacji

Błąd klasyfikacji (classification error) określa zależność

Trafność klasyfikowania (classification accuracy) określa zależność

Od podanej powyżej stosowanej zasady oceny istnieje wyjątek. Są to tzw. klasy niezrównoważone. Dotyczy to zadań w których liczba przypadków jest nierównomiernie rozłożona. Przykładem jest klasyfikowanie, czy transakcja kartą kredytową jest nadużyciem, czy nie, gdzie statystycznie jest 99,99% normalnych transakcji i tylko niewielki procent nadużyć. Klasyfikator, który mówi, że każda transakcja jest normalna, ma 99,99% trafności, ale nas interesują przede wszystkim te nieliczne klasyfikacje, które zdarzają się bardzo rzadko. Tego typu zagadnienia rozwiązuje się albo poprzez przebudowę algorytmów, albo bardziej powszechnie stosowane rozwiązanie – poprzez zmianę podejścia do próbkowania danych.

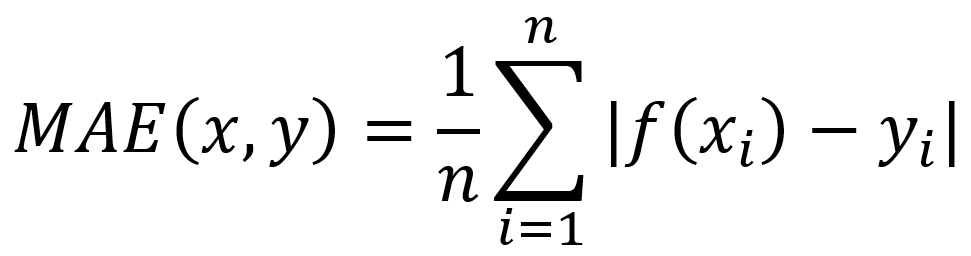

W ramach klasyfikacji binarnej dodatkowo stosuje się oceny

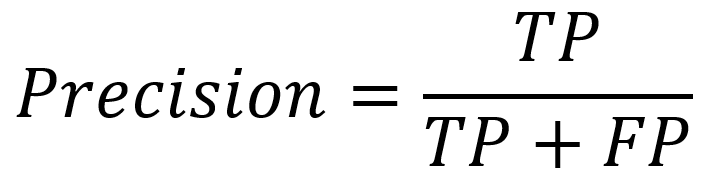

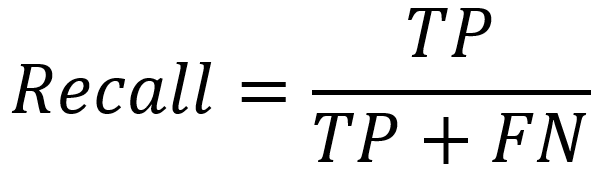

- Precyzja (precision) – proporcja elementów prawidłowo uznanych za pozytywne PP(ang. TP) do wszystkich elementów rzeczywiście pozytywnych

- Czułość (recall)- proporcja elementów prawidłowo uznanych za pozytywne PP (ang. TP) do sumy elementów prawidłowo i błędnie uznanych za pozytywne.

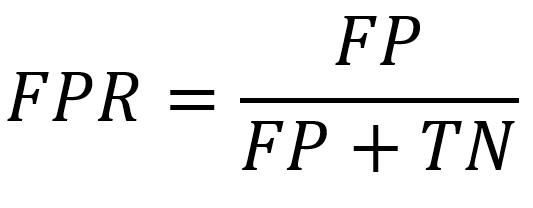

- Specyficzność FPR False Positive Rate określana wzorem:

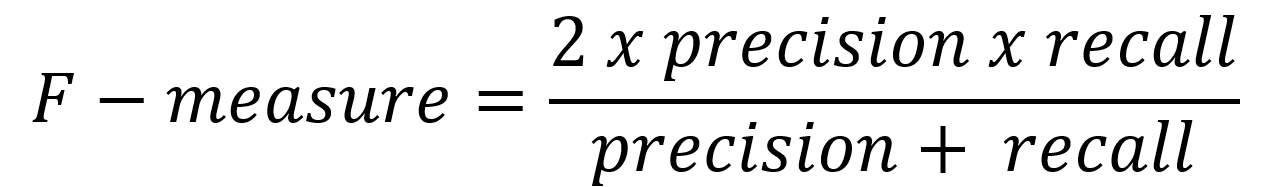

Powszechne jest łączenie tych dwóch pierwszych powyższych parametrów (Precision, Recall) i raportowanie miary F, która uwzględnia zarówno precyzję, jak i czułość, aby obliczyć wynik jako średnią ważoną, gdzie wynik osiąga najlepszą wartość przy 1, a najgorszą przy 0, w następujący sposób:

Ani sama precyzja, ani czułość nie opowiadają całej historii zdarzeń. Miara F odwołuje się do trzech danych – liczebność próby, liczby klas oraz środek klasy.

Po obliczeniu precyzji i czułości dla problemu klasyfikacji binarnej, oba wyniki można połączyć w obliczeniach F-Measure w jeden miarodajny wynik łączący wiele danych cząstkowych.

Przykład. Scenariusz – mamy linię produkcyjną sortowania jabłek której zadaniem jest oddzielenie jednego konkretnego gatunku „X” od jabłek innych gatunków. Załóżmy że nasza linia sortująca mierzy pewne parametry z maszyn na taśmie które są podłączone do naszej sztucznej inteligencji, a oczekiwana skuteczność sortowania ma być na poziomie F-measure na poziomie 0,95 (95%). Przykładowo są to następujące parametry:

- waga jabłka

- barwa jabłka

- kształt jabłka

Łatwo zauważyć że niektóre parametry wymuszają ocenę obrazu jabłka (dużo danych wzorców w pamięci) w związku z tym cały system poddaliśmy procesowi Machine Learning. Podczas uruchomienia próbnego partii 1000 jabłek otrzymaliśmy następującą macierz wyników sortowania maszynowego i pomiarów ręcznych laboratoryjnych tej samej partii (zakładamy że błąd pomiaru laboratoryjnego wynosi 0)

czyli

- 700 jabłek gatunku „X” rozpoznano i przesortowano prawidłowo,

- 250 jabłek innych gatunków rozpoznani i przesortowano prawidłowo,

- 30 jabłek rozpoznano jako inny gatunek a w rzeczywistości okazało się, że to jest gatunek „X”

- 20 jabłek innych gatunków rozpoznano nieprawidłowo jako gatunek „X”

obliczenia

Prec= 700/(700+30)=0,9589

Rec=700/(700+20)=0,9722

F-me= 2*0,9589*0,9722/(0,9589+0,97220= 0,9655 [96,55%]

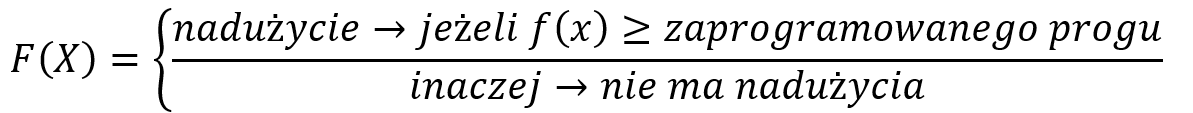

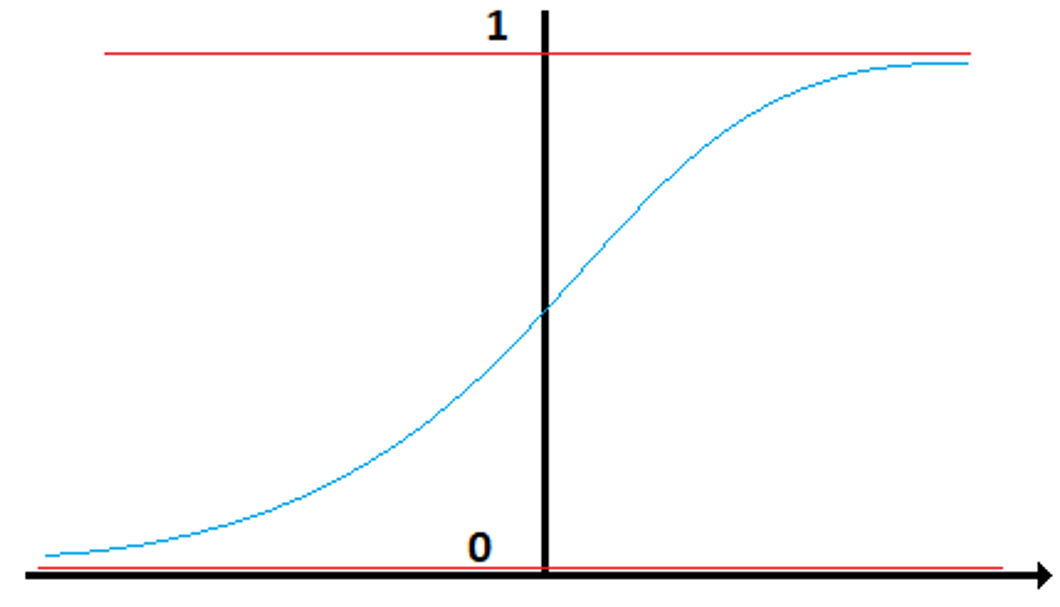

Klasyfikacja ROC

Istnieje jeszcze inna bardziej precyzyjna metoda klasyfikowania binarnego tzw. krzywa ROC. Powróćmy do rozważań nietypowego przypadku karty kredytowej. Większość algorytmów klasyfikacji zwraca ufność klasyfikacji oznaczoną jako f(X), która z kolei jest wykorzystywana do obliczenia predykcji. Zgodnie z przykładem nadużycia karty kredytowej reguła może wyglądać podobnie do następującej:

Jeśli tak to próg określa stopę błędu i rzeczywistą stopę dodatnią. Wyniki wszystkich możliwych wartości progowych można wykreślić jako progowe charakterystyki działań Receiver Operating Characteristics (ROC), jak to pokazano na poniższym diagramie:

Predykcja losowa jest wykreślona czerwoną linią przerywaną, a predykcja doskonała jest wykreślona zieloną linią przerywaną. Aby np. porównać, czy klasyfikator PR1 jest lepszy niż Pr2, porównujemy obszar pod krzywą, gdzie podstawą jest linia predykcji losowej, im większy obszar pod krzywą tym lepsze jest dopasowania progowe. Podsumowując krzywa ROC służy do porównania różnych modeli zbudowanych na postawie doboru argumentów czy też na podstawie wyboru różnych metod podejścia do rozwiązania problemu. Zaletą tej metody jest możliwość wizualizacji sytuacji decyzyjnej pod katem wartości progów oraz jakości (zbliżenia przyjętego modelu/algorytmu do ideału).

Przykład:*under construction*

Regresja

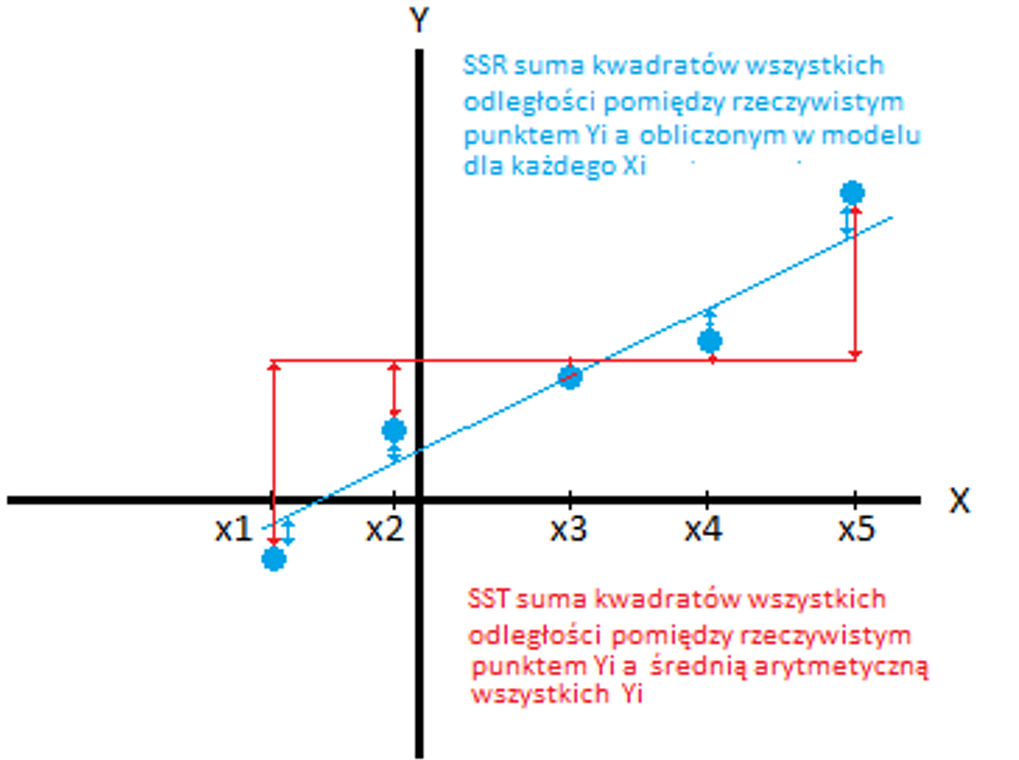

Regresja dotyczy ciągłej zmiennej docelowej, w przeciwieństwie do klasyfikacji, która działa z dyskretną zmienną docelową. Na przykład: aby przewidzieć temperaturę zewnętrzną na kilka następnych dni, użyjemy regresji, a klasyfikacja posłuży do przewidzenia, czy będzie padać, czy nie. Ogólnie rzecz biorąc, regresja to proces, który szacuje związek między cechami, czyli jak zróżnicowanie cechy zmienia zmienną docelową. Wynikiem regresji będzie model w postaci funkcji y=f(x).

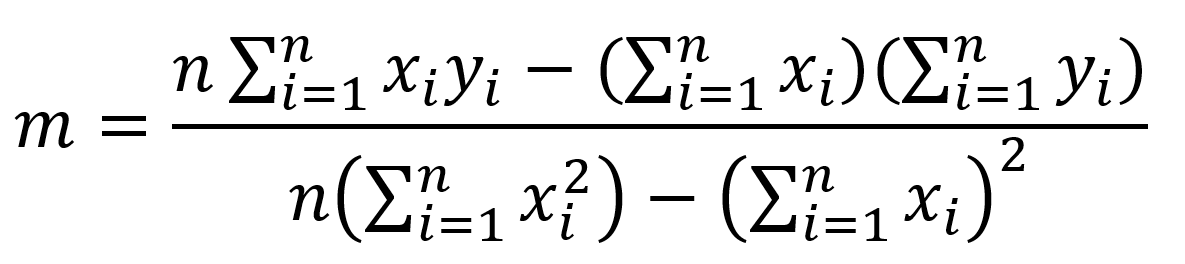

Regresja liniowa